系统管理员指南(1.15.3)

编辑人:酷酷的诚 邮箱:zhangchengk@foxmail.com

系统要求(System Requirements)

Apache NiFi可以运行在像笔记本电脑这样简单的设备上,同时它也可以在多个企业级服务器上以集群的方式运行。NiFi所需的硬件数量和内存大小与要处理的数据量相关。在NiFi处理数据时,数据是存储在磁盘上的(默认配置如此),因此,NiFi需要为其各种存储库(repository)分配足够的磁盘空间,尤其是内容存储库(content repository),流文件存储库(flowfile repository)和源文件存储库(provenance repository)(有关这些存储库的更多信息,请参阅系统属性(System Properties)部分)。

NiFi具有以下最低系统要求:

需要Java8或更Java11

支持的操作系统:

- Linux

- Unix

- Windows

- macOS

支持的Web浏览器:

- Microsoft Edge: Current & ((Current - 1)

- Mozilla FireFox: Current &(Current - 1)

- Google Chrome: Current &(Current - 1)

- Safari: Current &(Current - 1)

注意 在持续且极高的吞吐量下,可能需要调整

CodeCache(JVM)设置以避免突然的性能损失。有关更多信息,请参阅Bootstrap属性(Bootstrap Properties)部分。

如何安装和启动NiFi

Linux/Unix/macOS

- 解压NiFi到所需的安装目录

- 按照需要,配置

conf目录下的文件- 至少,我们建议你修改

nifi.properties文件并为nifi.sensitive.props.key设置一个密码值(请参阅下面的系统属性(System Properties)

- 至少,我们建议你修改

bin目录中,输入执行以下命令./nifi.sh <command>:- start:在后台启动NiFi

- stop:停止在后台运行的NiFi

- status:提供NiFi的当前状态

- run:在前台运行NiFi并等待

Ctrl-C命令来关闭NiFi - install:把NiFi安装为服务,然后可以通过以下命令控制NiFi

service NiFi startservice NiFi stopservice NiFi status

Windows

- 解压NiFi到所需的安装目录

- 按照需要配置

conf目录下的文件- 至少,我们建议你修改

nifi.properties文件并为nifi.sensitive.props.key设置一个密码值(请参阅下面的系统属性(System Properties))

- 至少,我们建议你修改

- 进入

bin目录 - 双击

run-nifi.bat,这会在前台运行NiFi并等待Ctrl-C命令来关闭NiFi - 要查看NiFi的当前状态,请双击

status-nifi.bat

首次启动NiFi时,会创建以下文件和目录:

content_repository目录database_repository目录flowfile_repository目录provenance_repository目录work目录logs目录- 在

conf目录中,将创建flow.xml.gz文件

For security purposes, when no security configuration is provided NiFi will now bind to 127.0.0.1 by default and the UI will only be accessible through this loopback interface. HTTPS properties should be configured to access NiFi from other interfaces. See the Security Configuration for guidance on how to do this.

Panda诚解读:上方官方文档有误,故拷贝原文而不翻译,此处予以纠正。参照

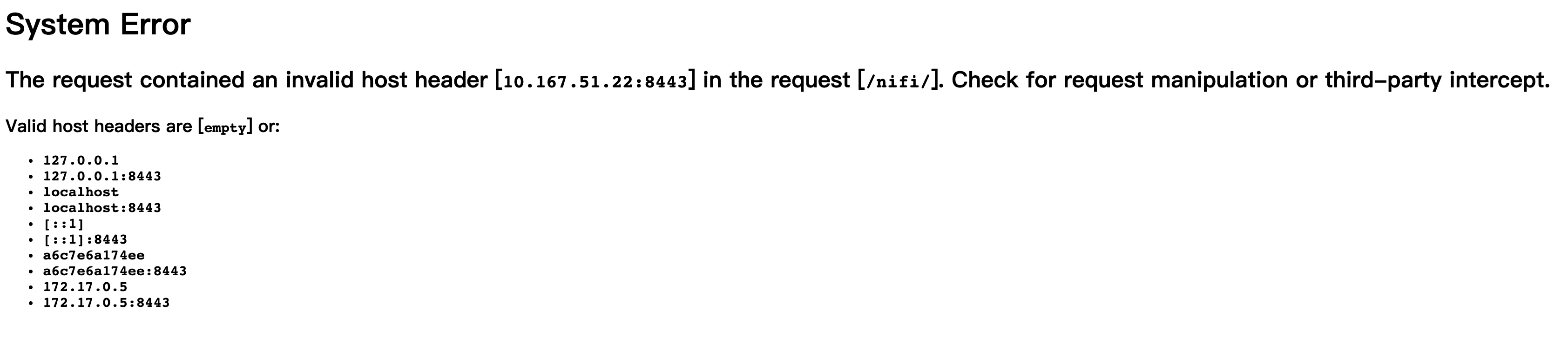

NIFI-8516 Enabled HTTPS and Single User Authentication in default configuration,现在的NiFi默认自动生成了证书以HTTPS模式启动,并使用single user的用户登陆和权限验证机制,默认绑定到127.0.0.1:8443,你只能从这个地址(https://127.0.0.1:8443)去访问,一般上局域网内你将nifi.web.https.host这个值置空(或者使用0.0.0.0)就可以通过服务器或虚机的IP地址来访问了,个别的使用云环境或者使用了容器技术的无法访问NiFi的,就得考虑配置nifi.web.proxy.host才能进一步通过具体的IP:Port来访问NiFi的界面。比如我测试起了一个docker镜像运行NiFi,如果我没有像如图配置proxy就会报类似如下的错误

有关配置NiFi存储库和配置文件的更多信息,请参阅本指南的系统属性(System Properties)部分。

端口配置(Port Configuration)

NiFi

下表列出了NiFi使用的默认端口以及nifi.properties文件中的对应属性。

| 功能 | 属性 | 默认值 |

|---|---|---|

| HTTPS Port* | nifi.web.https.port | 8443 |

| Remote Input Socket Port* | nifi.remote.input.socket.port | 10443 |

| Cluster Node Protocol Port* | nifi.cluster.node.protocol.port | 11443 |

| Cluster Node Load Balancing Port | nifi.cluster.node.load.balance.port | 6342 |

| Web HTTP Forwarding Port | nifi.web.http.port.forwarding | none |

标有星号(*)的端口的属性值在

nifi.properties中默认是空的。当使用TLS Toolkit生成安全的NiFi实例时,表中显示的值是这些端口在nifi.properties的默认值。注意,TLS Toolkit使用的HTTPS端口默认是9443,而不是8443。

嵌入式Zookeeper(Embedded ZooKeeper)

下表列出了嵌入式ZooKeeper服务器(Embedded ZooKeeper Server)使用的默认端口以及zookeeper.properties文件中的相应属性。

| 功能 | 属性 | 默认值 |

|---|---|---|

| Zookeeper Server Quorum and Leader Election Ports | server.1 | none |

| Zookeeper Client Port(弃用:从NiFi 1.10.x开始,不再在单独的行上指定客户端端口) | clientPort | 2181 |

Zookeeper服务器端口的注释示例包含在

zookeeper.properties文件中,格式为server.N=nifi-nodeN-hostname:2888:3888;2181。

配置最佳实践(Configuration Best Practices)

如果你在Linux上运行,请考虑这些最佳实践。典型的Linux默认设置不一定能够满足像NiFi这样的IO密集型应用程序的需求。对于这些最佳实践,对于不同的Linux发行版,实际情况可能会有所不同,可以参考下面的介绍,但是请参考特定Linux发行版的文档。

最大文件句柄(Maximum File Handles)

NiFi在任何时候都可能会打开非常大量的文件句柄。通过编辑/etc/security/limits.conf来增加限制,添加类似的内容

* hard nofile 50000 * soft nofile 50000

最大派生进程数(Maximum Forked Processes)

NiFi可以配置生成大量的线程。要增加Linux允许的数量,请编辑/etc/security/limits.conf

* hard nproc 10000 * soft nproc 10000

你的发行版Linux可能需要编辑/etc/security/limits.d/90-nproc.conf

* soft nproc 10000

增加可用的TCP套接字端口数(Increase the number of TCP socket ports available)

如果你的流程将在短时间内建立并拆除大量套接字,则如下配置尤其重要。

sudo sysctl -w net.ipv4.ip_local_port_range ="10000 65000"

设置套接字在关闭时保持TIMED_WAIT状态的时间(Set how long sockets stay in a TIMED_WAIT state when closed)

考虑到你希望能够快速设置和拆卸新套接字,你不希望你的套接字停留太长时间。最好多阅读一下并调整类似的东西

kernel 2.6

sudo sysctl -w net.ipv4.netfilter.ip_conntrack_tcp_timeout_time_wait ="1"

kernel 3.0

sudo sysctl -w net.netfilter.nf_conntrack_tcp_timeout_time_wait="1"

告诉Linux你永远不希望NiFi发生swap(Tell Linux you never want NiFi to swap)

对于某些应用程序来说,swapping非常棒,但对于像NiFi这样一直想要运行的程序来说并不好。要告诉Linux你想关掉swapping,你可以编辑/etc/sysctl.conf来添加以下行

vm.swappiness = 0

对于各种NiFi repos的分区,请关闭诸如atime之类的选项。这样做会导致吞吐量得到惊人的提高。编辑/etc/fstab文件,对于感兴趣的分区,添加noatime选项。

推荐病毒扫描排除(Recommended Antivirus Exclusions)

防病毒软件可能需要很长时间才能扫描完大型目录及其中的大量文件。此外,如果防病毒软件在扫描过程中锁定了文件或目录,则这些资源将无法用于NiFi进程,从而导致这些资源在NiFi实例/群集中的延迟或不可用。为防止出现这些性能和可靠性问题,强烈建议将防病毒软件配置为跳过对以下NiFi目录的扫描:

content_repositoryflowfile_repositorylogsprovenance_repositorystate

安全配置(Security Configuration)

出于安全目的NiFi提供了多种不同的配置选项。最重要的是nifi.properties文件中security properties(安全属性)标题下的属性。为了安全运行,必须设置以下属性:

| Property Name | Description |

|---|---|

nifi.security.keystore | 包含服务器私钥的密钥库的文件名。 |

nifi.security.keystoreType | 密钥库的类型,必须为PKCS12或JKS。JKS是首选类型,BCFKS和PKCS12文件将通过BouncyCastle提供程序加载。 |

nifi.security.keystorePasswd | 密钥库的密码。 |

nifi.security.keyPasswd | 密钥库中证书的密码。如果未设置,将使用nifi.security.keystorePasswd的值。 |

nifi.security.truststore | 信任库的文件名,将用于授权那些连接到NiFi的用户。没有Truststore的安全实例将拒绝所有传入连接。 |

nifi.security.truststoreType | 信任库的类型。必须为PKCS12或JKS。 JKS是首选类型,BCFKS和PKCS12文件将通过BouncyCastle提供程序加载。 |

nifi.security.truststorePasswd | 信任库的密码。 |

一旦配置了上述属性,我们就可以通过HTTPS而不是HTTP来访问用户界面。这是通过设置nifi.web.https.host和nifi.web.https.port属性来实现的。nifi.web.https.host属性指示服务器应在哪个主机名上运行。如果希望可以从所有网络接口访问HTTPS的NiFi,则应使用0.0.0.0值。为了允许管理员将应用程序配置为仅在特定的网络接口上运行,可以指定nifi.web.http.network.interface*或nifi.web.https.network.interface*属性。

启用HTTPS时重要的是取消设置

nifi.web.http.port属性。NiFi仅支持在HTTP或HTTPS上运行,而不是同时两种都支持。

当没有配置需要单向SSL(例如LDAP,OpenId Connect等)的替代认证机制时,NiFi的Web服务器将要求那些来访问NiFi用户界面的用户去使用基于证书的客户端身份验证。启用一个身份验证机制会将Web服务器配置为基于WANT证书的客户端身份验证。这将允许它支持具有证书的用户,而没有证书的用户可以使用凭证登录。有关详细信息,请参阅用户认证(User Authentication)

Panda诚解读:此处描述有异议,新版本提供了默认的用户认证机制(single user),而不是基于证书的认证了。

现在用户界面已经受到保护,接下来我们也可以轻松保护Site-to-Site的连接和内部集群通信,这是通过分别设置nifi.remote.input.secure和nifi.cluster.protocol.is.secure属性为true来实现的。这些通信总是需要双向SSL,因为节点将使用其配置的keystore/truststore进行验证。

NiFi的web SSL上下文的自动刷新可以使用以下属性进行启用:

| Property Name | Description |

|---|---|

nifi.security.autoreload.enabled | 指定如果检测到密钥存储库和信任存储库的更新,是否应自动重新加载SSL上下文。缺省值为false。 |

nifi.security.autoreload.interval | 指定检查密钥存储库和信任存储库更新的时间间隔。仅当nifi.security.autoreload.enabled设置为true时适用。缺省值是10秒。 |

一旦将nifi.security.autoreload.enabled属性设置为true,任何对配置的密钥存储库和信任存储库的有效更改都将导致NiFi的SSL上下文被重新加载,从而允许客户端获取这些更改。这是为了允许在密钥库中更新过期的证书,并在信任库中添加新的受信任的证书,而不需要重启NiFi服务器。

对任何

nifi.security.keystore*或者nifi.security.truststore*的更改都不会被自动刷新逻辑获取,它假定密码和存储路径保持不变。

TLS生成工具包(TLS Generation Toolkit)

为了便于NiFi的安全设置,你可以使用tls-toolkit命令行使程序自动生成所需的keystores, truststore和相关配置文件。这对于保护多个NiFi节点特别有用,这可能是一个单调乏味且容易出错的过程。有关更多信息,请参阅NiFi工具包指南中的TLS工具包部分。相关主题包括:

TLS密码套件(TLS Cipher Suites)

Java运行时环境提供了指定服务器在接受客户端连接时使用的自定义TLS加密套件的能力。请点击这里了解更多信息。要在NiFi web服务中使用此特性,可以设置以下NiFi属性:

| Property Name | Description |

|---|---|

nifi.web.https.ciphersuites.include | 一组可供传入的客户端连接使用的密码。替换系统默认值(如果设置)。 |

nifi.web.https.ciphersuites.exclude | 一组不能被传入的客户端连接使用的密码。过滤可用的密码(如果设置)。 |

每个属性应该采用逗号分隔的常见密码名列表的形式,如这里所指定的。也可以指定正则表达式(例如^.*GCM_SHA256$)。

语义匹配使用以下Jetty api:

用户认证(User Authentication)

NiFi支持通过客户端证书,用户名/密码,Apache Knox或OpenId Connect进行用户身份验证。

用户名/密码的验证是由Login Identity Provider执行的,Login Identity Provider是一种可插拔的机制。在nifi.properties文件中配置要使用的Login Identity Provider。目前的NiFi在Login Identity Provider提供了带有用户名/密码登陆的认证选项:Single User,轻量级目录访问协议(LDAP)和Kerberos。

nifi.login.identity.provider.configuration.file属性指定Login Identity Provider的配置文件。默认情况下,此属性设置为./conf/login-identity-providers.xml。

nifi.security.user.login.identity.provider属性指示应使用哪个已配置的Login Identity Provider。默认情况下,配置为single-user-provider,使用的是自动生成的用户名密码。

在OpenId Connect身份验证期间,NiFi会在返回NiFi之前将用户重定向到提供商的登录页面。然后,NiFi将调用第三方提供商以获取用户身份。

在Apache Knox身份验证期间,NiFi将重定向用户以使用Apache Knox登录,然后再返回NiFi。NiFi将在身份验证期间验证Apache Knox令牌。

NiFi只能配置为

用户名/密码,OpenId Connect或Apache Knox中的一个。它不支持同时运行多个。如果没有配置这些,则NiFi将需要客户端证书来通过HTTPS对用户进行身份验证。

除非将nifi.security.allow.anonymous.authentication设置为true,否则用户不能使用安全的NiFi实例进行匿名认证。如果设置为true了,NiFi还必须配置一个支持授权匿名用户的授权器,目前,NiFi没有发布过这样的授权器,但未来会努力解决这些问题的(NiFi-2730)。

在设置nifi.security.allow.anonymous.authentication时需要考虑三个场景。当用户直接调用端点而没有尝试身份验证时,nifi.security.allow.anonymous.authentication将控制请求是被身份验证通过还是被拒绝。另外两种情况是请求被代理时,可以是由NiFi节点(例如NiFi集群中的节点)代理,也可能是由代理匿名用户请求的独立代理。在这些代理场景中,nifi.security.allow.anonymous.authentication将控制请求是被身份验证通过还是被拒绝。在所有这三个场景中,如果请求经过身份验证,它随后将基于所请求的资源接受正常授权。

NiFi不通过HTTP执行用户身份验证。使用HTTP,所有用户都将被授予所有角色,拥有所有权限。

单用户(Single User)

默认的Single User Login Identity Provider支持自动生成用户名和密码。

生成的用户名将是由36个字符组成的随机UUID。生成的密码将是一个由32个字符组成的随机字符串,并bcrypt哈希。

nifi.properties中的默认配置是启用了单用户身份验证:

nifi.security.user.login.identity.provider=single-user-provider

默认的login-identity-providers.xml包含一个空白的provider:

<provider>

<identifier>single-user-provider</identifier>

<class>org.apache.nifi.authentication.single.user.SingleUserLoginIdentityProvider</class>

<property name="Username"/>

<property name="Password"/>

</provider>

使用下面的命令可以修改用户名密码

$ ./bin/nifi.sh set-single-user-credentials <username> <password>

轻量级目录访问协议(LDAP)

以下是配置Login Identity Provider的示例和说明,该Login Identity Provider与Directory Server集成以对用户进行身份验证。

在nifi.properties中设置以下内容以启用LDAP username/password身份验证:

nifi.security.user.login.identity.provider=ldap-provider

修改login-identity-providers.xml以启用ldap-provider。以下是文件中提供的示例:

<provider>

<identifier>ldap-provider</identifier>

<class>org.apache.nifi.ldap.LdapProvider</class>

<property name="Authentication Strategy">START_TLS</property>

<property name="Manager DN"></property>

<property name="Manager Password"></property>

<property name="TLS - Keystore"></property>

<property name="TLS - Keystore Password"></property>

<property name="TLS - Keystore Type"></property>

<property name="TLS - Truststore"></property>

<property name="TLS - Truststore Password"></property>

<property name="TLS - Truststore Type"></property>

<property name="TLS - Client Auth"></property>

<property name="TLS - Protocol"></property>

<property name="TLS - Shutdown Gracefully"></property>

<property name="Referral Strategy">FOLLOW</property>

<property name="Connect Timeout">10 secs</property>

<property name="Read Timeout">10 secs</property>

<property name="Url"></property>

<property name="User Search Base"></property>

<property name="User Search Filter"></property>

<property name="Identity Strategy">USE_DN</property>

<property name="Authentication Expiration">12 hours</property>

</provider>

ldap-provider具有以下属性:

| 属性名称 | 描述 |

|---|---|

Authentication Expiration | 用户身份验证有效期的持续时间。如果用户从未注销,则需要在此持续时间之后重新登录。 |

Authentication Strategy | 如何验证与LDAP服务器的连接。可能的值是ANONYMOUS,SIMPLE,LDAPS,或START_TLS。 |

Manager DN | 用于绑定到LDAP服务器以搜索用户的管理器的DN。 |

Manager Password | 用于绑定到LDAP服务器以搜索用户的管理器的密码。 |

TLS - Keystore | 使用LDAPS或START_TLS连接到LDAP时使用的密钥库的路径。 |

TLS - Keystore Password | 使用LDAPS或START_TLS连接到LDAP时使用的密钥库的密码。 |

TLS - Keystore Type | 使用LDAPS或START_TLS(即JKS或PKCS12)连接到LDAP时使用的密钥库的类型。 |

TLS - Truststore | 使用LDAPS或START_TLS连接到LDAP时使用的Truststore的路径。 |

TLS - Truststore Password | 使用LDAPS或START_TLS连接到LDAP时使用的Truststore的密码。 |

TLS - Truststore Type | 使用LDAPS或START_TLS(即JKS或PKCS12)连接到LDAP时使用的Truststore的类型。 |

TLS - Client Auth | 使用LDAPS或START_TLS连接到LDAP时的客户端身份验证策略。可能的值是REQUIRED,WANT,NONE。 |

TLS - Protocol | 使用LDAPS或START_TLS连接到LDAP时使用的协议。(即TLS,TLSv1.1,TLSv1.2,等等)。 |

TLS - Shutdown Gracefully | 指定在关闭目标上下文之前是否应正常关闭TLS。默认为false。 |

Referral Strategy | 处理推荐的策略。可能的值是FOLLOW,IGNORE,THROW。 |

Connect Timeout | 连接超时的持续时间。(即10 secs)。 |

Read Timeout | 读取超时的持续时间。(即10 secs)。 |

Url | 以空格分隔的LDAP服务器的URL列表(即ldap://<hostname>:<port>)。 |

User Search Base | 用于搜索用户的基本DN(即CN=Users,DC=example,DC=com)。 |

User Search Filter | 过滤搜索用户User Search Base。(即sAMAccountName={0})。用户指定的名称将插入"{0}"。 |

Identity Strategy | 识别用户的策略。可能的值是USE_DN和USE_USERNAME。缺少此属性的默认功能是USE_DN,以保持向后兼容性。USE_DN将尽可能使用用户条目的完整DN。USE_USERNAME将使用用户登录的用户名。 |

要使

nifi.properties和login-identity-providers.xml的更改生效,需要重新启动NiFi。如果NiFi是集群的,所有节点上的配置文件必须相同。

Kerberos

以下是配置与Kerberos Key Distribution Center (KDC)集成以验证用户身份的Login Identity Provider的示例和说明。

在nifi.properties中设置以下内容以启用Kerberos username/password身份验证:

nifi.security.user.login.identity.provider=kerberos-provider

修改login-identity-providers.xml以启用kerberos-provider。以下是文件中提供的示例:

<provider>

<identifier>kerberos-provider</identifier>

<class>org.apache.nifi.kerberos.KerberosProvider</class>

<property name="Default Realm">nifi.APACHE.ORG</property>

<property name="Authentication Expiration">12 hours</property>

</provider>

kerberos-provider具有以下属性:

| Property Name | Description |

|---|---|

Default Realm | 当用户输入不完整的用户主体时要提供的默认域 (i.e. nifi.APACHE.ORG). |

Authentication Expiration | 用户认证的有效时间。如果用户从未登出,则将要求他们在这段时间后重新登录。 |

如果要通过Kerberos进行单点登录访问请参见Kerberos服务(Kerberos Service)。

对于

nifi.properties和login-identity-providers.xml的更改要生效,需要重新启动NiFi。NiFi集群时,所有节点的配置文件必须一致。

OpenId Connect

要通过OpenId Connect启用身份验证,必须在nifi.properties中配置以下属性。

| Property Name | Description |

|---|---|

nifi.security.user.oidc.discovery.url | The discovery URL for the desired OpenId Connect Provider (link:http://openid.net/specs/openid-connect-discovery-1_0.html[http://openid.net/specs/openid-connect-discovery-1_0.html^]). |

nifi.security.user.oidc.connect.timeout | Connect timeout when communicating with the OpenId Connect Provider. |

nifi.security.user.oidc.read.timeout | Read timeout when communicating with the OpenId Connect Provider. |

nifi.security.user.oidc.client.id | The client id for NiFi after registration with the OpenId Connect Provider. |

nifi.security.user.oidc.client.secret | The client secret for NiFi after registration with the OpenId Connect Provider. |

nifi.security.user.oidc.preferred.jwsalgorithm | The preferred algorithm for validating identity tokens. If this value is blank, it will default to RS256 which is required to be supported |

by the OpenId Connect Provider according to the specification. If this value is HS256, HS384, or HS512, NiFi will attempt to validate HMAC protected tokens using the specified client secret. | |

If this value is none, NiFi will attempt to validate unsecured/plain tokens. Other values for this algorithm will attempt to parse as an RSA or EC algorithm to be used in conjunction with the | |

| JSON Web Key (JWK) provided through the jwks_uri in the metadata found at the discovery URL. | |

nifi.security.user.oidc.additional.scopes | Comma separated scopes that are sent to OpenId Connect Provider in addition to openid and email. |

nifi.security.user.oidc.claim.identifying.user | Claim that identifies the user to be logged in; default is email. May need to be requested via the nifi.security.user.oidc.additional.scopes before usage. |

nifi.security.user.oidc.fallback.claims.identifying.user | Comma separated possible fallback claims used to identify the user in case nifi.security.user.oidc.claim.identifying.user claim is not present for the login user. |

SAML

要通过SAML启用身份验证,必须在nifi.properties中配置以下属性。

| Property Name | Description |

|---|---|

nifi.security.user.saml.idp.metadata.url | The URL for obtaining the identity provider's metadata. The metadata can be retrieved from the identity provider via http:// or https://, or a local file can be referenced using file:// . |

nifi.security.user.saml.sp.entity.id | The entity id of the service provider (i.e. NiFi). This value will be used as the Issuer for SAML authentication requests and should be a valid URI. In some cases the service provider entity id must be registered ahead of time with the identity provider. |

nifi.security.user.saml.identity.attribute.name | The name of a SAML assertion attribute containing the user'sidentity. This property is optional and if not specified, or if the attribute is not found, then the NameID of the Subject will be used. |

nifi.security.user.saml.group.attribute.name | The name of a SAML assertion attribute containing group names the user belongs to. This property is optional, but if populated the groups will be passed along to the authorization process. |

nifi.security.user.saml.metadata.signing.enabled | Enables signing of the generated service provider metadata. |

nifi.security.user.saml.request.signing.enabled | Controls the value of AuthnRequestsSigned in the generated service provider metadata from NiFi-api/access/saml/metadata. This indicates that the service provider (i.e. NiFi) should not sign authentication requests sent to the identity provider, but the requests may still need to be signed if the identity provider indicates WantAuthnRequestSigned=true. |

nifi.security.user.saml.want.assertions.signed | Controls the value of WantAssertionsSigned in the generated service provider metadata from NiFi-api/access/saml/metadata. This indicates that the identity provider should sign assertions, but some identity providers may provide their own configuration for controlling whether assertions are signed. |

nifi.security.user.saml.signature.algorithm | The algorithm to use when signing SAML messages. Reference the link:https://git.shibboleth.net/view/?p=java-xmltooling.git;a=blob;f=src/main/java/org/opensaml/xml/signature/SignatureConstants.java[Open SAML Signature Constants] for a list of valid values. If not specified, a default of SHA-256 will be used. |

nifi.security.user.saml.signature.digest.algorithm | The digest algorithm to use when signing SAML messages. Reference the link:https://git.shibboleth.net/view/?p=java-xmltooling.git;a=blob;f=src/main/java/org/opensaml/xml/signature/SignatureConstants.java[Open SAML Signature Constants] for a list of valid values. If not specified, a default of SHA-256 will be used. |

nifi.security.user.saml.message.logging.enabled | Enables logging of SAML messages for debugging purposes. |

nifi.security.user.saml.authentication.expiration | The expiration of the NiFi JWT that will be produced from a successful SAML authentication response. |

nifi.security.user.saml.single.logout.enabled | Enables SAML SingleLogout which causes a logout from NiFi to logout of the identity provider. By default, a logout of NiFi will only remove the NiFi JWT. |

nifi.security.user.saml.http.client.truststore.strategy | The truststore strategy when the IDP metadata URL begins with https. A value of JDK indicates to use the JDK's default truststore. A value ofNiFiindicates to use the truststore specified by nifi.security.truststore. |

nifi.security.user.saml.http.client.connect.timeout | The connection timeout when communicating with the SAML IDP. |

nifi.security.user.saml.http.client.read.timeout | The read timeout when communicating with the SAML IDP. |

Apache Knox

要通过Apache Knox启用身份验证,必须在nifi.properties中配置以下属性。

| 属性名称 | 描述 |

|---|---|

nifi.security.user.knox.audiences | 可选的。逗号分隔列出的允许的受众群体。如果设置,则令牌中的受众必须出现在此列表中。可以在Knox中配置令牌中填充的受众。 |

nifi.security.user.knox.url | Apache Knox登录页面的URL。 |

nifi.security.user.knox.publicKey | Apache Knox公钥的路径,用于验证HTTP Cookie中的身份验证令牌的签名。 |

nifi.security.user.knox.cookieName | 成功登录后Apache Knox将生成的HTTP Cookie的名称。 |

JSON Web Tokens

在登录后NiFi使用JSON Web token提供身份验证访问。生成的JSON Web Token包括经过身份验证的用户标识,以及配置的Login Identity Provider的发行人和过期时间。

NiFi使用生成的RSA密钥对,密钥大小为4096位,支持JSON Web签名的PS512算法。系统使用配置的local State Provider存储RSA Public Key,并将RSA Private Key保存在内存中。这种方法不需要持久化私钥就支持在Login Identity Provider中配置带过期时间的签名验证。

JSON Web Token支持包括注销时使用JSON Web Token标识符的撤销。系统根据Login Identity Provider配置拒绝过期的令牌的访问,而撤销令牌会在过期前使其失效。系统使用配置的local State Provider存储已撤销的标识符,并在过期后执行定时命令删除已撤销的标识符。

在NiFi中可以进行以下属性来控制JSON Web Token签名。

| Property Name | Description |nifi.security.user.jws.key.rotation.period | JSON Web签名密钥旋转周期定义了系统多长时间生成一个新的RSA密钥对,表示为ISO 8601持续时间。默认值为1小时:' PT1H '

Panda诚解读:关于更多关于NIFI

JSON Web token的解读,访问公众号NIFI系列文章中查阅文章,,篇幅很长这里就不展开了。

多租户授权(Multi-Tenant Authorization)

将NiFi配置为安全运行并具有身份认证机制后,必须配置谁有权访问系统以及他们的访问级别。你可以使用多租户授权来执行此操作。多租户授权使多组用户(租户)可以使用不同的授权级别来命令,控制和观察数据流的不同部分。当通过身份验证的用户尝试查看或修改NiFi资源时,系统会检查该用户是否具有执行该操作的权限。这些权限由可以在系统范围或单个组件中应用的策略(Policy)定义。

授权器(Authorizer Configuration)

authorizer在NiFi初始化授权的时候,授予用户管理用户和策略的权限。

使用nifi.properties文件中的两个属性配置授权器:

nifi.authorizer.configuration.file属性指定定义授权器的配置文件。默认情况下,将选择位于conf目录中的authorizers.xml文件。nifi.security.user.authorizer属性指示authorizers.xml文件中要使用的哪个已配置的授权器。

Authorizers.xml设置

The authorizers.xml file is used to define and configure available authorizers. The default authorizer is the StandardManagedAuthorizer. The managed authorizer is comprised of a UserGroupProvider and a AccessPolicyProvider. The users, group, and access policies will be loaded and optionally configured through these providers. The managed authorizer will make all access decisions based on these provided users, groups, and access policies.

Panda诚解读:上述官方文档描述有误,故在此进行纠正:默认

authorizers.xml文件用于定义和配置可用的授权器。默认的授权器是SingleUserAuthorizer(已经不是StandardManagedAuthorizer了)。 授权器下NiFi定义了一个托管授权器(managed authorizer),一个托管授权器由UserGroupProvider(管理users和group)和AccessPolicyProvider(管理Policy)组成,托管授权器将根据这些Provider提供的users,group,和access policies做出所有访问决定。托管授权器的原理是我们自定义开发NiFi授权模块的必要知识。

在启动过程中,将进行检查以确保不存在两个具有相同identity/name的users/groups。不管配置的实现如何,都会执行此检查,这是必需的,因为这是在访问决策期间识别和授权users/groups的方式。

FileUserGroupProvider

StandardManagedAuthorizer默认的UserGroupProvider是FileUserGroupProvider,但是,你可以开发其他UserGroupProvider作为扩展。 FileUserGroupProvider具有以下属性:

- 用户文件(Users File) - FileUserGroupProvider存储用户和租户的文件。默认情况下,使用

conf目录中的users.xml文件。 - 旧版授权用户文件(Legacy Authorized Users File) - authorized-users.xml的完整路径,该路径将自动用于将用户和租户加载到用户文件中。

- 初始用户身份(Initial User Identity) - 用户和系统的标识,用于添加到用户文件(Users File)中。每个属性的名称必须是唯一的,例如:"Initial User Identity A","Initial User Identity B","Initial User Identity C"或者"Initial User Identity 1","Initial User Identity 2","Initial User Identity 3"。

LdapUserGroupProvider

UserGroupProvider的另一个选项是LdapUserGroupProvider。默认情况下,此选项已注释掉,但可以配置代替FileUserGroupProvider。这将从目录服务器同步用户和租户,并以只读形式在NiFi UI中显示它们。

LdapUserGroupProvider具有以下属性:

| Property Name | Description |

|---|---|

Authentication Strategy | How the connection to the LDAP server is authenticated. Possible values are ANONYMOUS, SIMPLE, LDAPS, or START_TLS. |

Manager DN | The DN of the manager that is used to bind to the LDAP server to search for users. |

Manager Password | The password of the manager that is used to bind to the LDAP server to search for users. |

TLS - Keystore | Path to the Keystore that is used when connecting to LDAP using LDAPS or START_TLS. |

TLS - Keystore Password | Password for the Keystore that is used when connecting to LDAP using LDAPS or START_TLS. |

TLS - Keystore Type | Type of the Keystore that is used when connecting to LDAP using LDAPS or START_TLS (i.e. JKS or PKCS12). |

TLS - Truststore | Path to the Truststore that is used when connecting to LDAP using LDAPS or START_TLS. |

TLS - Truststore Password | Password for the Truststore that is used when connecting to LDAP using LDAPS or START_TLS. |

TLS - Truststore Type | Type of the Truststore that is used when connecting to LDAP using LDAPS or START_TLS (i.e. JKS or PKCS12). |

TLS - Client Auth | Client authentication policy when connecting to LDAP using LDAPS or START_TLS. Possible values are REQUIRED, WANT, NONE. |

TLS - Protocol | Protocol to use when connecting to LDAP using LDAPS or START_TLS. (i.e. TLS, TLSv1.1, TLSv1.2, etc). |

TLS - Shutdown Gracefully | Specifies whether the TLS should be shut down gracefully before the target context is closed. Defaults to false. |

Referral Strategy | Strategy for handling referrals. Possible values are FOLLOW, IGNORE, THROW. |

Connect Timeout | Duration of connect timeout. (i.e. 10 secs). |

Read Timeout | Duration of read timeout. (i.e. 10 secs). |

Url | Space-separated list of URLs of the LDAP servers (i.e. ldap://<hostname>:<port>). |

Page Size | Sets the page size when retrieving users and groups. If not specified, no paging is performed. |

Group Membership - Enforce Case Sensitivity | Sets whether group membership decisions are case sensitive. When a user or group is inferred (by not specifying or user or group search base or user identity attribute or group name attribute) case sensitivity is enforced since the value to use for the user identity or group name would be ambiguous. Defaults to false. |

Sync Interval | Duration of time between syncing users and groups. (i.e. 30 mins). Minimum allowable value is 10 secs. |

User Search Base | Base DN for searching for users (i.e. ou=users,o=NiFi). Required to search users. |

User Object Class | Object class for identifying users (i.e. person). Required if searching users. |

User Search Scope | Search scope for searching users (ONE_LEVEL, OBJECT, or SUBTREE). Required if searching users. |

User Search Filter | Filter for searching for users against the User Search Base (i.e. (memberof=cn=team1,ou=groups,o=NiFi)). Optional. |

User Identity Attribute | Attribute to use to extract user identity (i.e. cn). Optional. If not set, the entire DN is used. |

User Group Name Attribute | Attribute to use to define group membership (i.e. memberof). Optional. If not set group membership will not be calculated through the users. Will rely on group membership being defined through Group Member Attribute if set. The value of this property is the name of the attribute in the user ldap entry that associates them with a group. The value of that user attribute could be a dn or group name for instance. What value is expected is configured in the User Group Name Attribute - Referenced Group Attribute. |

User Group Name Attribute - Referenced Group Attribute | If blank, the value of the attribute defined in User Group Name Attribute is expected to be the full dn of the group. If not blank, this property will define the attribute of the group ldap entry that the value of the attribute defined in User Group Name Attribute is referencing (i.e. name). Use of this property requires that Group Search Base is also configured. |

Group Search Base | Base DN for searching for groups (i.e. ou=groups,o=NiFi). Required to search groups. |

Group Object Class | Object class for identifying groups (i.e. groupOfNames). Required if searching groups. |

Group Search Scope | Search scope for searching groups (ONE_LEVEL, OBJECT, or SUBTREE). Required if searching groups. |

Group Search Filter | Filter for searching for groups against the Group Search Base. Optional. |

Group Name Attribute | Attribute to use to extract group name (i.e. cn). Optional. If not set, the entire DN is used. |

Group Member Attribute | Attribute to use to define group membership (i.e. member). Optional. If not set group membership will not be calculated through the groups. Will rely on group membership being defined through User Group Name Attribute if set. The value of this property is the name of the attribute in the group ldap entry that associates them with a user. The value of that group attribute could be a dn or memberUid for instance. What value is expected is configured in the Group Member Attribute - Referenced User Attribute. (i.e. member: cn=User 1,ou=users,o=NiFi vs. memberUid: user1) |

Group Member Attribute - Referenced User Attribute | If blank, the value of the attribute defined in Group Member Attribute is expected to be the full dn of the user. If not blank, this property will define the attribute of the user ldap entry that the value of the attribute defined in Group Member Attribute is referencing (i.e. uid). Use of this property requires that User Search Base is also configured. (i.e. member: cn=User 1,ou=users,o=NiFi vs. memberUid: user1) |

nifi.properties中指定的identity mapping rules也将应用于user identities。Group名称不会被映射替换。

ShellUserGroupProvider

ShellUserGroupProvider使用Shell命令从类似Unix的系统中获取用户和租户户详细信息。该提供程序使用诸如Linux上的getent和MacOS上的dscl之类的命令执行各种Shell管道。可以将受支持的系统配置为从外部来源(例如LDAP或NIS)检索用户和租户。在这些情况下,shell命令将返回这些外部用户和租户。这为管理员提供了另一种集成用户和租户目录服务的机制。 ShellUserGroupProvider具有以下属性:

| Property Name | Description |

|---|---|

Initial Refresh Delay | Duration of initial delay before first user and group refresh. (i.e. 10 secs). Default is 5 mins. |

Refresh Delay | Duration of delay between each user and group refresh. (i.e. 10 secs). Default is 5 mins. |

Exclude Groups | Regular expression used to exclude groups. Default is '', which means no groups are excluded. |

Exclude Users | Regular expression used to exclude users. Default is '', which means no users are excluded. |

与LdapUserGroupProvider一样,ShellUserGroupProvider在authorizers.xml文件中被注释掉。有关用法示例,请参阅该注释。

AzureGraphUserGroupProvider

The AzureGraphUserGroupProvider fetches users and groups from Azure Active Directory (AAD) using the Microsoft Graph API.

A subset of groups are fetched based on filter conditions (Group Filter Prefix, Group Filter Suffix, Group Filter Substring, and Group Filter List Inclusion) evaluated against the displayName property of the Azure AD group. Member users are then loaded from these groups. At least one filter condition should be specified.

This provider requires an Azure app registration with:

- Microsoft Graph Group.Read.All and User.Read.All API permissions with admin consent

- A client secret or application password

- ID token claims for upn and/or email

See here and here for more information on how to create a valid app registration.

The AzureGraphUserGroupProvider has the following properties:

| Property Name | Description |

|---|---|

Refresh Delay | Duration of delay between each user and group refresh. Default is 5 mins. |

Authority Endpoint | The endpoint of the Azure AD login. This can be found in the Azure portal under Azure Active Directory → App registrations → [application name] → Endpoints. For example, the global authority endpoint is https://login.microsoftonline.com. |

Directory ID | Tenant ID or Directory ID of the Azure AD tenant. This can be found in the Azure portal under Azure Active Directory → App registrations → [application name] → Directory (tenant) ID. |

Application ID | Client ID or Application ID of the Azure app registration. This can be found in the Azure portal under Azure Active Directory → App registrations → [application name] → Overview → Application (client) ID. |

Client Secret | A client secret from the Azure app registration. Secrets can be created in the Azure portal under Azure Active Directory → App registrations → [application name] → Certificates & secrets → Client secrets → [+] New client secret. |

Group Filter Prefix | Prefix filter for Azure AD groups. Matches against the group displayName to retrieve only groups with names starting with the provided prefix. |

Group Filter Suffix | Suffix filter for Azure AD groups. Matches against the group displayName to retrieve only groups with names ending with the provided suffix. |

Group Filter Substring | Substring filter for Azure AD groups. Matches against the group displayName to retrieve only groups with names containing the provided substring. |

Group Filter List Inclusion | Comma-separated list of Azure AD groups. If no string-based matching filter (i.e., prefix, suffix, and substring) is specified, set this property to avoid fetching all groups and users in the Azure AD tenant. |

Page Size | Page size to use with the Microsoft Graph API. Set to 0 to disable paging API calls. Default: 50, Max: 999. |

Claim for Username | The property of the user directory object mapped to the NiFi user name field. Default is 'upn'. 'email' is another option when nifi.security.user.oidc.fallback.claims.identifying.user is set to 'upn'. |

Like LdapUserGroupProvider and ShellUserGroupProvider, the AzureGraphUserGroupProvider configuration is commented out in the authorizers.xmlfile. Refer to the comment for a starter configuration.

CompositeUserGroupProvider

UAnother option for the UserGroupProvider are composite implementations. This means that multiple sources/implementations can be configured and composed. For instance, an admin can configure users/groups to be loaded from a file and a directory server. There are two composite implementations, one that supports multiple UserGroupProviders and one that supports multiple UserGroupProviders and a single configurable UserGroupProvider.

The CompositeUserGroupProvider will provide support for retrieving users and groups from multiple sources. The CompositeUserGroupProvider has the following property:

| Property Name | Description |

|---|---|

User Group Provider [unique key] | The identifier of user group providers to load from. The name of each property must be unique, for example: "User Group Provider A", "User Group Provider B", "User Group Provider C" or "User Group Provider 1", "User Group Provider 2", "User Group Provider 3" |

Any identity mapping rules specified in nifi.properties are not applied in this implementation. This behavior would need to be applied by the base implementation.

The CompositeConfigurableUserGroupProvider will provide support for retrieving users and groups from multiple sources. Additionally, a single configurable user group provider is required. Users from the configurable user group provider are configurable, however users loaded from one of the User Group Provider [unique key] will not be. The CompositeConfigurableUserGroupProvider has the following properties:

| Property Name | Description |

|---|---|

Configurable User Group Provider | A configurable user group provider. |

User Group Provider [unique key] | The identifier of user group providers to load from. The name of each property must be unique, for example: "User Group Provider A", "User Group Provider B", "User Group Provider C" or "User Group Provider 1", "User Group Provider 2", "User Group Provider 3" |

FileAccessPolicyProvider

StandardManagedAuthorizer默认的AccessPolicyProvider是FileAccessPolicyProvider,但是,你可以开发其他AccessPolicyProvider作为扩展。 FileAccessPolicyProvider具有以下属性:

| Property Name | Description |

|---|---|

User Group Provider | The identifier for an User Group Provider defined above that will be used to access users and groups for use in the managed access policies. |

Authorizations File | The file where the FileAccessPolicyProvider will store policies. |

Initial Admin Identity | The identity of an initial admin user that will be granted access to the UI and given the ability to create additional users, groups, and policies. The value of this property could be a DN when using certificates or LDAP, or a Kerberos principal. This property will only be used when there are no other policies defined. If this property is specified then a Legacy Authorized Users File can not be specified. |

Legacy Authorized Users File | The full path to an existing authorized-users.xml that will be automatically converted to the new authorizations model. If this property is specified then an Initial Admin Identity can not be specified, and this property will only be used when there are no other users, groups, and policies defined. |

Node Identity | The identity of a NiFi cluster node. When clustered, a property for each node should be defined, so that every node knows about every other node. If not clustered these properties can be ignored. The name of each property must be unique, for example for a three node cluster: "Node Identity A", "Node Identity B", "Node Identity C" or "Node Identity 1", "Node Identity 2", "Node Identity 3" |

Node Group | The name of a group containing NiFi cluster nodes. The typical use for this is when nodes are dynamically added/removed from the cluster. |

The identities configured in the Initial Admin Identity, the Node Identity properties, or discovered in a Legacy Authorized Users File must be available in the configured User Group Provider.

Any users in the legacy users file must be found in the configured User Group Provider.

Any identity mapping rules specified in nifi.properties will also be applied to the node identities, so the values should be the unmapped identities (i.e. full DN from a certificate). This identity must be found in the configured User Group Provider.

StandardManagedAuthorizer

The default authorizer is the StandardManagedAuthorizer, however, you can develop additional authorizers as extensions. The StandardManagedAuthorizer has the following property:

| Property Name | Description |

|---|---|

Access Policy Provider | The identifier for an Access Policy Provider defined above. |

FileAuthorizer

FileAuthorizer已被上述更精细的StandardManagedAuthorizer方法取代。但是,由于向后兼容的原因,它仍然可用。 FileAuthorizer具有以下属性:

| Property Name | Description |

|---|---|

Authorizations File | The file where the FileAuthorizer stores policies. By default, the authorizations.xml in the conf directory is chosen. |

Users File | The file where the FileAuthorizer stores users and groups. By default, the users.xml in the conf directory is chosen. |

Initial Admin Identity | The identity of an initial admin user that is granted access to the UI and given the ability to create additional users, groups, and policies. This property is only used when there are no other users, groups, and policies defined. |

Legacy Authorized Users File | The full path to an existing authorized-users.xml that is automatically converted to the multi-tenant authorization model. This property is only used when there are no other users, groups, and policies defined. |

Node Identity | The identity of a NiFi cluster node. When clustered, a property for each node should be defined, so that every node knows about every other node. If not clustered, these properties can be ignored. |

Any identity mapping rules specified in nifi.properties will also be applied to the initial admin identity, so the value should be the unmapped identity.

Any identity mapping rules specified in nifi.properties will also be applied to the node identities, so the values should be the unmapped identities (i.e. full DN from a certificate).

初始化管理员(新NiFi实例)

如果你是第一次设置安全的NiFi实例,则必须在authorizers.xml文件中手动指定Initial Admin Identity。此初始管理员用户被授予对UI的访问权限,并且可以创建其他用户,租户和策略。此属性的值可以是DN(使用证书或LDAP时)或Kerberos主体。如果你是NiFi管理员,请将自己添加为Initial Admin Identity。

编辑并保存authorizers.xml文件后,重新启动NiFi。重新启动期间,Initial Admin Identity这个用户和系统管理员级别的策略将添加到users.xml和authorizations.xml文件中。一旦NiFi启动,Initial Admin Identity用户就可以访问UI并开始管理用户,租户和策略。

对于全新的安全流程,提供

Initial Admin Identity使该用户可以访问UI并管理用户,租户和策略。但是,如果该用户要开始修改流,则需要为root进程组授予自己的策略。系统无法自动执行此操作,因为在新流程中,根流程组的UUID在生成flow.xml.gz之前不是永久的。如果NiFi实例是从现有flow.xml.gz的升级或从不安全到安全的1.x实例的升级,则将自动为Initial Admin Identity用户授予修改流程的权限。

一些常见用例如下所述。

基于文件(LDAP身份验证)

以下是使用John Smith名称的LDAP条目示例:

<authorizers>

<userGroupProvider>

<identifier>file-user-group-provider</identifier>

<class>org.apache.nifi.authorization.FileUserGroupProvider</class>

<property name="Users File">./conf/users.xml</property>

<property name="Legacy Authorized Users File"></property>

<property name="Initial User Identity 1">cn=John Smith,ou=people,dc=example,dc=com</property>

</userGroupProvider>

<accessPolicyProvider>

<identifier>file-access-policy-provider</identifier>

<class>org.apache.nifi.authorization.FileAccessPolicyProvider</class>

<property name="User Group Provider">file-user-group-provider</property>

<property name="Authorizations File">./conf/authorizations.xml</property>

<property name="Initial Admin Identity">cn=John Smith,ou=people,dc=example,dc=com</property>

<property name="Legacy Authorized Users File"></property>

<property name="Node Identity 1"></property>

</accessPolicyProvider>

<authorizer>

<identifier>managed-authorizer</identifier>

<class>org.apache.nifi.authorization.StandardManagedAuthorizer</class>

<property name="Access Policy Provider">file-access-policy-provider</property>

</authorizer>

</authorizers>

基于文件(Kerberos身份验证)

以下是使用名称John Smith和realm的示例Kerberos条目NIFI.APACHE.ORG:

<authorizers>

<userGroupProvider>

<identifier>file-user-group-provider</identifier>

<class>org.apache.nifi.authorization.FileUserGroupProvider</class>

<property name="Users File">./conf/users.xml</property>

<property name="Legacy Authorized Users File"></property>

<property name="Initial User Identity 1">johnsmith@nifi.APACHE.ORG</property>

</userGroupProvider>

<accessPolicyProvider>

<identifier>file-access-policy-provider</identifier>

<class>org.apache.nifi.authorization.FileAccessPolicyProvider</class>

<property name="User Group Provider">file-user-group-provider</property>

<property name="Authorizations File">./conf/authorizations.xml</property>

<property name="Initial Admin Identity">johnsmith@nifi.APACHE.ORG</property>

<property name="Legacy Authorized Users File"></property>

<property name="Node Identity 1"></property>

</accessPolicyProvider>

<authorizer>

<identifier>managed-authorizer</identifier>

<class>org.apache.nifi.authorization.StandardManagedAuthorizer</class>

<property name="Access Policy Provider">file-access-policy-provider</property>

</authorizer>

</authorizers>

基于LDAP的用户/组引用用户DN

以下是从LDAP加载用户和租户的示例。组成员资格将通过每个组的成员属性来驱动。授权仍将使用基于文件的访问策略:

dn: cn=User 1,ou=users,o=NiFi

objectClass: organizationalPerson

objectClass: person

objectClass: inetOrgPerson

objectClass: top

cn: User 1

sn: User1

uid: user1

dn: cn=User 2,ou=users,o=NiFi

objectClass: organizationalPerson

objectClass: person

objectClass: inetOrgPerson

objectClass: top

cn: User 2

sn: User2

uid: user2

dn: cn=admins,ou=groups,o=NiFi

objectClass: groupOfNames

objectClass: top

cn: admins

member: cn=User 1,ou=users,o=NiFi

member: cn=User 2,ou=users,o=NiFi

<authorizers>

<userGroupProvider>

<identifier>ldap-user-group-provider</identifier>

<class>org.apache.nifi.ldap.tenants.LdapUserGroupProvider</class>

<property name="Authentication Strategy">ANONYMOUS</property>

<property name="Manager DN"></property>

<property name="Manager Password"></property>

<property name="TLS - Keystore"></property>

<property name="TLS - Keystore Password"></property>

<property name="TLS - Keystore Type"></property>

<property name="TLS - Truststore"></property>

<property name="TLS - Truststore Password"></property>

<property name="TLS - Truststore Type"></property>

<property name="TLS - Client Auth"></property>

<property name="TLS - Protocol"></property>

<property name="TLS - Shutdown Gracefully"></property>

<property name="Referral Strategy">FOLLOW</property>

<property name="Connect Timeout">10 secs</property>

<property name="Read Timeout">10 secs</property>

<property name="Url">ldap://localhost:10389</property>

<property name="Page Size"></property>

<property name="Sync Interval">30 mins</property>

<property name="User Search Base">ou=users,o=NiFi</property>

<property name="User Object Class">person</property>

<property name="User Search Scope">ONE_LEVEL</property>

<property name="User Search Filter"></property>

<property name="User Identity Attribute">cn</property>

<property name="User Group Name Attribute"></property>

<property name="User Group Name Attribute - Referenced Group Attribute"></property>

<property name="Group Search Base">ou=groups,o=NiFi</property>

<property name="Group Object Class">groupOfNames</property>

<property name="Group Search Scope">ONE_LEVEL</property>

<property name="Group Search Filter"></property>

<property name="Group Name Attribute">cn</property>

<property name="Group Member Attribute">member</property>

<property name="Group Member Attribute - Referenced User Attribute"></property>

</userGroupProvider>

<accessPolicyProvider>

<identifier>file-access-policy-provider</identifier>

<class>org.apache.nifi.authorization.FileAccessPolicyProvider</class>

<property name="User Group Provider">ldap-user-group-provider</property>

<property name="Authorizations File">./conf/authorizations.xml</property>

<property name="Initial Admin Identity">John Smith</property>

<property name="Legacy Authorized Users File"></property>

<property name="Node Identity 1"></property>

</accessPolicyProvider>

<authorizer>

<identifier>managed-authorizer</identifier>

<class>org.apache.nifi.authorization.StandardManagedAuthorizer</class>

<property name="Access Policy Provider">file-access-policy-provider</property>

</authorizer>

</authorizers>

根据User Identity Attribute,Initial Admin Identity将从John Smith的条目的cn中加载。

LDAP-based Users/Groups Referencing User Attribute

Here is an example loading users and groups from LDAP. Group membership will be driven through the member uid attribute of each group. Authorization will still use file-based access policies:

dn: uid=User 1,ou=Users,dc=local

objectClass: inetOrgPerson

objectClass: posixAccount

objectClass: shadowAccount

uid: user1

cn: User 1

dn: uid=User 2,ou=Users,dc=local

objectClass: inetOrgPerson

objectClass: posixAccount

objectClass: shadowAccount

uid: user2

cn: User 2

dn: cn=Managers,ou=Groups,dc=local

objectClass: posixGroup

cn: Managers

memberUid: user1

memberUid: user2

<authorizers>

<userGroupProvider>

<identifier>ldap-user-group-provider</identifier>

<class>org.apache.nifi.ldap.tenants.LdapUserGroupProvider</class>

<property name="Authentication Strategy">ANONYMOUS</property>

<property name="Manager DN"></property>

<property name="Manager Password"></property>

<property name="TLS - Keystore"></property>

<property name="TLS - Keystore Password"></property>

<property name="TLS - Keystore Type"></property>

<property name="TLS - Truststore"></property>

<property name="TLS - Truststore Password"></property>

<property name="TLS - Truststore Type"></property>

<property name="TLS - Client Auth"></property>

<property name="TLS - Protocol"></property>

<property name="TLS - Shutdown Gracefully"></property>

<property name="Referral Strategy">FOLLOW</property>

<property name="Connect Timeout">10 secs</property>

<property name="Read Timeout">10 secs</property>

<property name="Url">ldap://localhost:10389</property>

<property name="Page Size"></property>

<property name="Sync Interval">30 mins</property>

<property name="User Search Base">ou=Users,dc=local</property>

<property name="User Object Class">posixAccount</property>

<property name="User Search Scope">ONE_LEVEL</property>

<property name="User Search Filter"></property>

<property name="User Identity Attribute">cn</property>

<property name="User Group Name Attribute"></property>

<property name="User Group Name Attribute - Referenced Group Attribute"></property>

<property name="Group Search Base">ou=Groups,dc=local</property>

<property name="Group Object Class">posixGroup</property>

<property name="Group Search Scope">ONE_LEVEL</property>

<property name="Group Search Filter"></property>

<property name="Group Name Attribute">cn</property>

<property name="Group Member Attribute">memberUid</property>

<property name="Group Member Attribute - Referenced User Attribute">uid</property>

</userGroupProvider>

<accessPolicyProvider>

<identifier>file-access-policy-provider</identifier>

<class>org.apache.nifi.authorization.FileAccessPolicyProvider</class>

<property name="User Group Provider">ldap-user-group-provider</property>

<property name="Authorizations File">./conf/authorizations.xml</property>

<property name="Initial Admin Identity">John Smith</property>

<property name="Legacy Authorized Users File"></property>

<property name="Node Identity 1"></property>

</accessPolicyProvider>

<authorizer>

<identifier>managed-authorizer</identifier>

<class>org.apache.nifi.authorization.StandardManagedAuthorizer</class>

<property name="Access Policy Provider">file-access-policy-provider</property>

</authorizer>

</authorizers>

Composite - File and LDAP-based Users/Groups

Here is an example composite implementation loading users and groups from LDAP and a local file. Group membership will be driven through the member attribute of each group. The users from LDAP will be read only while the users loaded from the file will be configurable in UI.

dn: cn=User 1,ou=users,o=NiFi

objectClass: organizationalPerson

objectClass: person

objectClass: inetOrgPerson

objectClass: top

cn: User 1

sn: User1

uid: user1

dn: cn=User 2,ou=users,o=NiFi

objectClass: organizationalPerson

objectClass: person

objectClass: inetOrgPerson

objectClass: top

cn: User 2

sn: User2

uid: user2

dn: cn=admins,ou=groups,o=NiFi

objectClass: groupOfNames

objectClass: top

cn: admins

member: cn=User 1,ou=users,o=NiFi

member: cn=User 2,ou=users,o=NiFi

<authorizers>

<userGroupProvider>

<identifier>file-user-group-provider</identifier>

<class>org.apache.nifi.authorization.FileUserGroupProvider</class>

<property name="Users File">./conf/users.xml</property>

<property name="Legacy Authorized Users File"></property>

<property name="Initial User Identity 1">cn=NiFi-node1,ou=servers,dc=example,dc=com</property>

<property name="Initial User Identity 2">cn=NiFi-node2,ou=servers,dc=example,dc=com</property>

</userGroupProvider>

<userGroupProvider>

<identifier>ldap-user-group-provider</identifier>

<class>org.apache.nifi.ldap.tenants.LdapUserGroupProvider</class>

<property name="Authentication Strategy">ANONYMOUS</property>

<property name="Manager DN"></property>

<property name="Manager Password"></property>

<property name="TLS - Keystore"></property>

<property name="TLS - Keystore Password"></property>

<property name="TLS - Keystore Type"></property>

<property name="TLS - Truststore"></property>

<property name="TLS - Truststore Password"></property>

<property name="TLS - Truststore Type"></property>

<property name="TLS - Client Auth"></property>

<property name="TLS - Protocol"></property>

<property name="TLS - Shutdown Gracefully"></property>

<property name="Referral Strategy">FOLLOW</property>

<property name="Connect Timeout">10 secs</property>

<property name="Read Timeout">10 secs</property>

<property name="Url">ldap://localhost:10389</property>

<property name="Page Size"></property>

<property name="Sync Interval">30 mins</property>

<property name="User Search Base">ou=users,o=NiFi</property>

<property name="User Object Class">person</property>

<property name="User Search Scope">ONE_LEVEL</property>

<property name="User Search Filter"></property>

<property name="User Identity Attribute">cn</property>

<property name="User Group Name Attribute"></property>

<property name="User Group Name Attribute - Referenced Group Attribute"></property>

<property name="Group Search Base">ou=groups,o=NiFi</property>

<property name="Group Object Class">groupOfNames</property>

<property name="Group Search Scope">ONE_LEVEL</property>

<property name="Group Search Filter"></property>

<property name="Group Name Attribute">cn</property>

<property name="Group Member Attribute">member</property>

<property name="Group Member Attribute - Referenced User Attribute"></property>

</userGroupProvider>

<userGroupProvider>

<identifier>composite-user-group-provider</identifier>

<class>org.apache.nifi.authorization.CompositeConfigurableUserGroupProvider</class>

<property name="Configurable User Group Provider">file-user-group-provider</property>

<property name="User Group Provider 1">ldap-user-group-provider</property>

</userGroupProvider>

<accessPolicyProvider>

<identifier>file-access-policy-provider</identifier>

<class>org.apache.nifi.authorization.FileAccessPolicyProvider</class>

<property name="User Group Provider">composite-user-group-provider</property>

<property name="Authorizations File">./conf/authorizations.xml</property>

<property name="Initial Admin Identity">John Smith</property>

<property name="Legacy Authorized Users File"></property>

<property name="Node Identity 1">cn=NiFi-node1,ou=servers,dc=example,dc=com</property>

<property name="Node Identity 2">cn=NiFi-node2,ou=servers,dc=example,dc=com</property>

</accessPolicyProvider>

<authorizer>

<identifier>managed-authorizer</identifier>

<class>org.apache.nifi.authorization.StandardManagedAuthorizer</class>

<property name="Access Policy Provider">file-access-policy-provider</property>

</authorizer>

</authorizers>

In this example, the users and groups are loaded from LDAP but the servers are managed in a local file. The Initial Admin Identity value came from an attribute in a LDAP entry based on the User Identity Attribute. The Node Identity values are established in the local file using the Initial User Identity properties.

旧版授权用户(NiFi实例升级)

If you are upgrading from a 0.x NiFi instance, you can convert your previously configured users and roles to the multi-tenant authorization model. In the authorizers.xml file, specify the location of your existing authorized-users.xml file in the Legacy Authorized Users File property.

Here is an example entry:

<authorizers>

<userGroupProvider>

<identifier>file-user-group-provider</identifier>

<class>org.apache.nifi.authorization.FileUserGroupProvider</class>

<property name="Users File">./conf/users.xml</property>

<property name="Legacy Authorized Users File">/Users/johnsmith/config_files/authorized-users.xml</property>

<property name="Initial User Identity 1"></property>

</userGroupProvider>

<accessPolicyProvider>

<identifier>file-access-policy-provider</identifier>

<class>org.apache.nifi.authorization.FileAccessPolicyProvider</class>

<property name="User Group Provider">file-user-group-provider</property>

<property name="Authorizations File">./conf/authorizations.xml</property>

<property name="Initial Admin Identity"></property>

<property name="Legacy Authorized Users File">/Users/johnsmith/config_files/authorized-users.xml</property>

<property name="Node Identity 1"></property>

</accessPolicyProvider>

<authorizer>

<identifier>managed-authorizer</identifier>

<class>org.apache.nifi.authorization.StandardManagedAuthorizer</class>

<property name="Access Policy Provider">file-access-policy-provider</property>

</authorizer>

</authorizers>

After you have edited and saved the authorizers.xml file, restart NiFi. Users and roles from the authorized-users.xml file are converted and added as identities and policies in the users.xml and authorizations.xml files. Once the application starts, users who previously had a legacy Administrator role can access the UI and begin managing users, groups, and policies.

The following tables summarize the global and component policies assigned to each legacy role if the NiFi instance has an existing flow.xml.gz:

全局访问政策

| Admin | DFM | Monitor | Provenance | NiFi | Proxy | |

|---|---|---|---|---|---|---|

| view the UI | * | * | * | |||

| access the controller - view | * | * | * | * | ||

| access the controller - modify | * | |||||

| access parameter contexts - view | ||||||

| access parameter contexts - modify | ||||||

| query provenance | * | |||||

| access restricted components | * | |||||

| access all policies - view | * | |||||

| access all policies - modify | * | |||||

| access users/user groups - view | * | |||||

| access users/user groups - modify | * | |||||

| retrieve site-to-site details | * | |||||

| view system diagnostics | * | * | ||||

| proxy user requests | * | |||||

| access counters |

Root进程组上的组件访问策略

| Admin | DFM | Monitor | Provenance | NiFi | Proxy | |

|---|---|---|---|---|---|---|

| view the component | * | * | * | |||

| modify the component | * | |||||

| view the data | * | * | * | |||

| modify the data | * | * | ||||

| view provenance | * |

有关表中各个策略的详细信息,请参阅访问策略(Access Policies)。

如果属性

Initial Admin Identity和Legacy Authorized Users File属性都存在值,则NiFi无法重新启动。你只能指定其中一个值来初始化授权。

不要手动编辑

authorizations.xml文件。仅在初始设置期间以及之后使用NiFi UI创建授权。

集群节点标识(Cluster Node Identities)

如果在集群环境中运行NiFi,则必须为每个节点指定标识。在启动期间创建节点通信所需的授权策略。

例如,如果要为每个节点设置具有以下DN的2节点集群:

cn=NiFi-1,ou=people,dc=example,dc=com

cn=NiFi-2,ou=people,dc=example,dc=com

<authorizers>

<userGroupProvider>

<identifier>file-user-group-provider</identifier>

<class>org.apache.nifi.authorization.FileUserGroupProvider</class>

<property name="Users File">./conf/users.xml</property>

<property name="Legacy Authorized Users File"></property>

<property name="Initial User Identity 1">johnsmith@nifi.APACHE.ORG</property>

<property name="Initial User Identity 2">cn=NiFi-1,ou=people,dc=example,dc=com</property>

<property name="Initial User Identity 3">cn=NiFi-2,ou=people,dc=example,dc=com</property>

</userGroupProvider>

<accessPolicyProvider>

<identifier>file-access-policy-provider</identifier>

<class>org.apache.nifi.authorization.FileAccessPolicyProvider</class>

<property name="User Group Provider">file-user-group-provider</property>

<property name="Authorizations File">./conf/authorizations.xml</property>

<property name="Initial Admin Identity">johnsmith@nifi.APACHE.ORG</property>

<property name="Legacy Authorized Users File"></property>

<property name="Node Identity 1">cn=NiFi-1,ou=people,dc=example,dc=com</property>

<property name="Node Identity 2">cn=NiFi-2,ou=people,dc=example,dc=com</property>

</accessPolicyProvider>

<authorizer>

<identifier>managed-authorizer</identifier>

<class>org.apache.nifi.authorization.StandardManagedAuthorizer</class>

<property name="Access Policy Provider">file-access-policy-provider</property>

</authorizer>

</authorizers>

在集群中,所有节点必须具有相同的

authorizations.xml和users.xml。唯一的例外是,在加入集群之前,如果节点的authorizations.xml和user.xml文件为空。这种情况下,节点将在启动期间从集群继承它们。

现在已经创建了初始授权,可以在NiFi UI中创建和管理其他用户,租户和授权策略。

配置用户和访问策略(Configuring Users & Access Policies)

根据配置的UserGroupProvider和AccessPolicyProvider的功能,可以在UI中配置用户,租户和策略。

本节假定用户,租户和策略可在UI中配置,并描述:

- 如何创建用户和租户

- 访问策略如何用于定义授权

- 如何查看在用户上设置的策略

- 如何通过遍历特定示例来配置访问策略

以下说明假定User1是具有管理员权限的用户,例如

Initial Admin Identity用户或转换后的旧管理员用户(请参阅Authorizers.xml设置)。

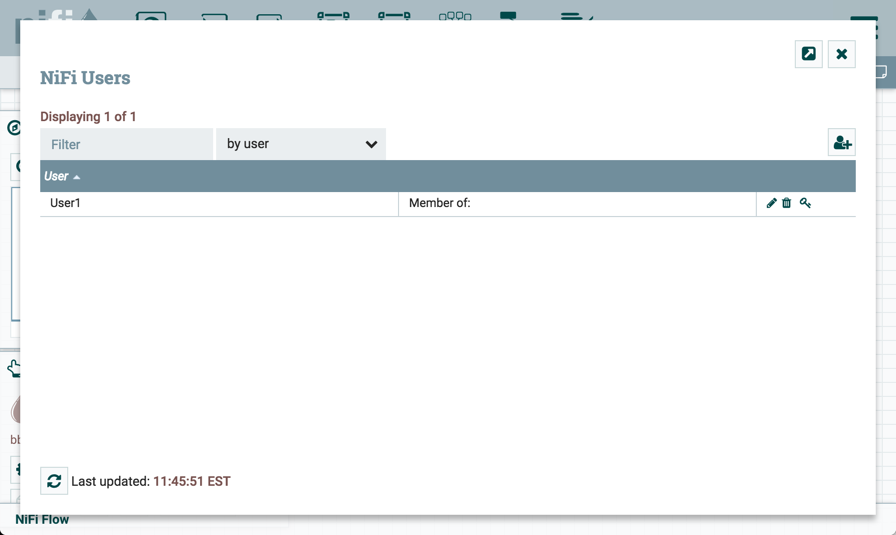

创建用户和租户(Creating Users and Groups)

在UI中,从全局菜单中选择Users。这将打开一个用于创建和管理用户和租户的对话框。

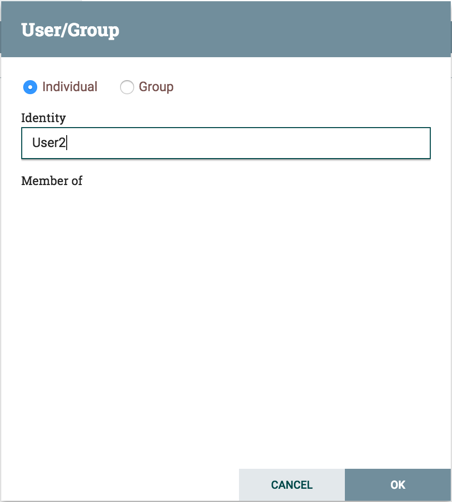

单击Add图标(![]() )。要创建用户,请输入与为保护你的NiFi实例而选择的身份验证方法相关的

)。要创建用户,请输入与为保护你的NiFi实例而选择的身份验证方法相关的Identity信息。单击确定。

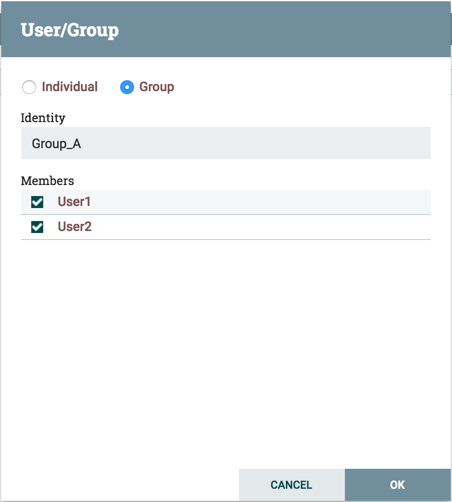

要创建租户,请选择"Group"单选按钮,输入组的名称,然后选择要包括在组中的用户。单击确定。

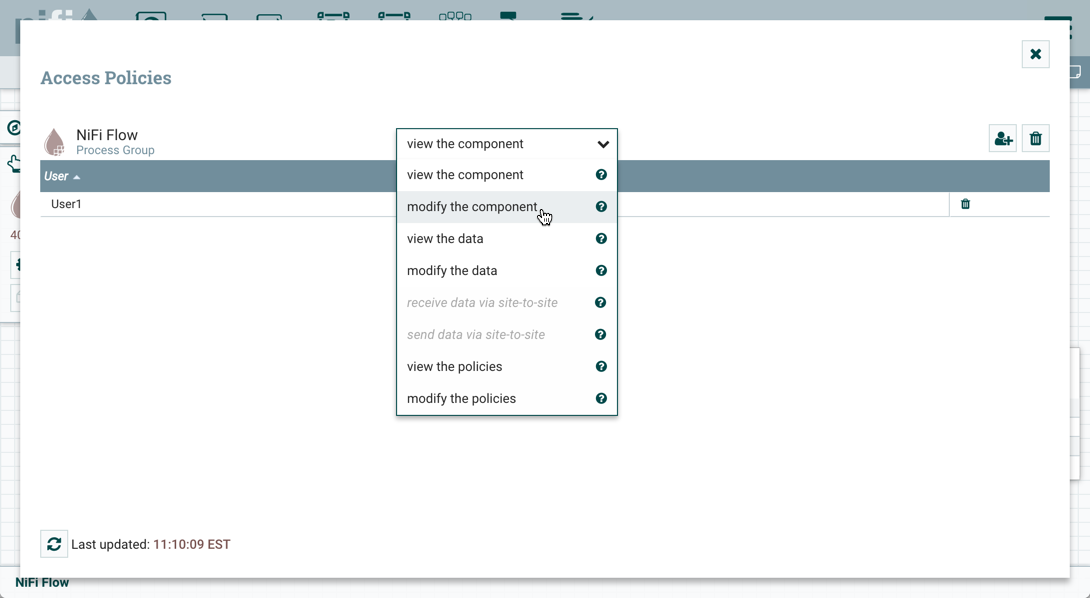

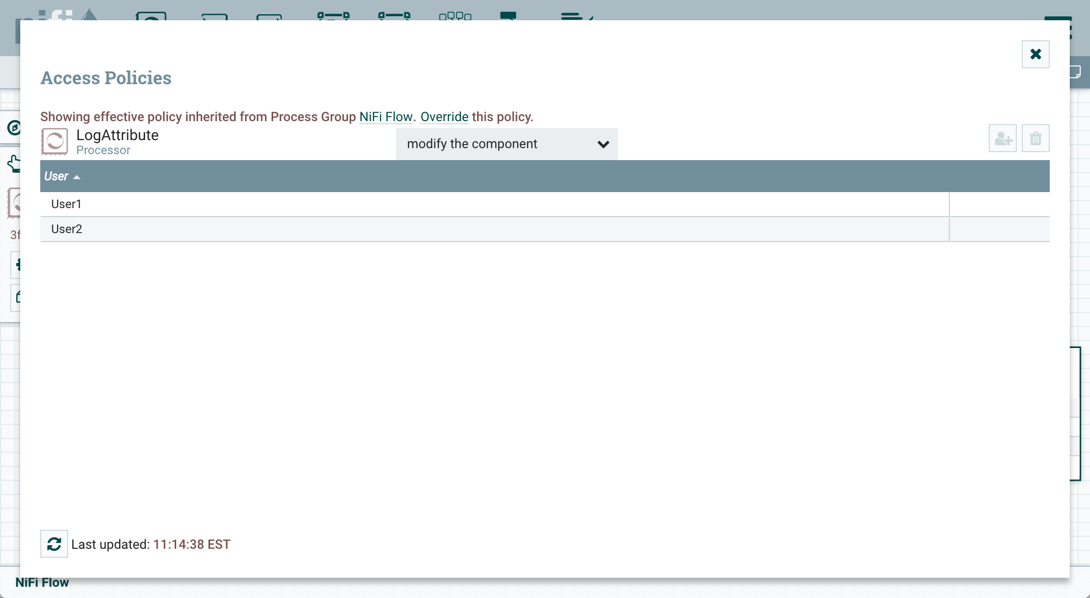

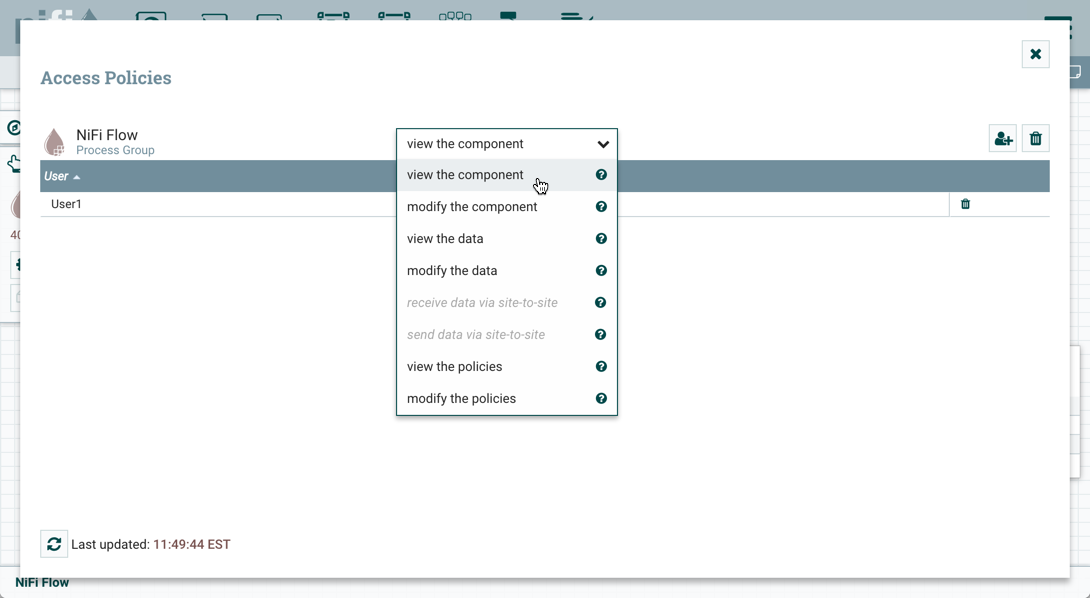

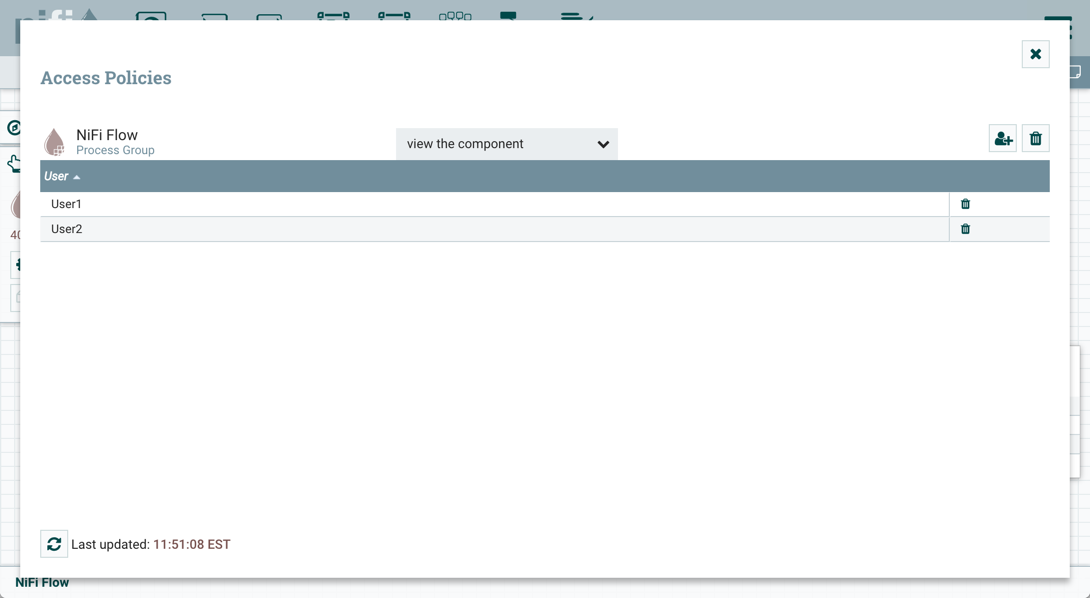

访问策略(Access Policies)

你可以使用"access policies"管理用户和租户查看或修改NiFi资源的能力。可以将两种类型的访问策略应用于资源:

View - 如果为资源创建了视图策略,则只有添加到该策略的用户或组才能看到该资源的详细信息。

Modify - 如果资源具有修改策略,则只有添加到该策略的用户或组才能更改该资源的配置。

你可以在全局和组件级别创建和应用访问策略。

全局访问政策

全局访问策略管理以下系统级授权:

| Policy | Privilege | Global Menu Selection | Resource Descriptor |

|---|---|---|---|

| view the UI | 允许用户查看UI | N/A | /flow |

| access the controller | 允许用户查看/修改控制器,包括报告任务,控制器服务,参数上下文和集群中的节点 | Controller Settings | /controller |

| access parameter contexts | 允许用户查看/修改参数上下文。除非被覆盖,否则对参数上下文的访问将从“access the controller”策略继承。 | Parameter Contexts | /parameter-contexts |

| query provenance | 允许用户提交Provenance Search和请求血缘关系 | Data Provenance | /provenance |

| access restricted components | 假设其他权限就足够了,允许用户创建/修改受限组件。受限组件可以指示需要哪些特定权限。可以授予特定限制的权限,也可以不受限制地授予权限。如果无论限制如何都授予许可,则用户可以创建/修改所有受限制的组件。 | N/A | /restricted-components |

| access all policies | 允许用户查看/修改所有组件的策略 | Policies | /policies |

| access users/user groups | 允许用户查看/修改用户和用户组 | Users | /tenants |

| retrieve site-to-site details | 允许其他NiFi实例检索站点到站点详细信息 | N/A | /site-to-site |

| view system diagnostics | 允许用户查看系统诊断 | Summary | /system |

| proxy user requests | 允许代理计算机代表他人发送请求 | N/A | /proxy |

| access counters | 允许用户查看/修改计数器 | Counters | /counters |

组���级访问策略

组件级访问策略管理以下组件级别授权:

| Policy | Privilege | Resource Descriptor & Action |

|---|---|---|

| view the component | 允许用户查看组件配置详细信息 | resource="/<component-type>/<component-UUID>" action="R" |

| modify the component | 允许用户修改组件配置详细信息 | resource="/<component-type>/<component-UUID>" action="W" |

| operate the component | 允许用户通过更改组件运行状态(启动/停止/启用/禁用),远程端口传输状态或终止处理器线程来操作组件 | resource="/operation/<component-type>/<component-UUID>" action="W" |

| view provenance | 允许用户查看此组件生成的provenance events | resource="/provenance-data/<component-type>/<component-UUID>" action="R" |

| view the data | 允许用户在出站连接中和通过provenance events查看流文件队列中该组件的元数据和内容 | resource="/data/<component-type>/<component-UUID>" action="R" |

| modify the data | 允许用户清空出站连接中的流文件队列,并通过provenance events提交重播 | resource="/data/<component-type>/<component-UUID>" action="W" |

| view the policies | 允许用户查看可以查看/修改组件的用户列表 | resource="/policies/<component-type>/<component-UUID>" action="R" |

| modify the policies | 允许用户修改可以查看/修改组件的用户列表 | resource="/policies/<component-type>/<component-UUID>" action="W" |

| receive data via site-to-site | 允许端口从NiFi实例接收数据 | resource="/data-transfer/input-ports/<port-UUID>" action="W" |

| send data via site-to-site | 允许端口从NiFi实例发送数据 | resource="/data-transfer/output-ports/<port-UUID>" action="W" |

你可以将访问策略应用于除连接之外的所有组件类型。连接授权由连接的源和目标组件上的各个访问策略以及包含组件的进程组的访问策略推断。在下面的创建连接和编辑连接示例中将对此进行更详细的讨论。

为了访问连接的列表队列或删除队列,用户需要在组件上"view the data"和"modify the data"策略的权限。在集群环境中,所有节点也必须添加到这些策略中,因为可以通过集群中的任何节点复制用户请求。

访问策略继承

管理员无需为数据流中的每个组件手动创建策略。为了减少管理员在授权管理上花费的时间,策略将从父资源继承到子资源。例如,如果授予用户查看和修改进程组的权限,则该用户还可以查看和修改进程组中的组件。策略继承使管理员可以一次分配策略,并在整个数据流中应用策略。

你可以覆盖继承的策略(如下面的移动处理器示例中所述)。覆盖策略会删除继承的策略,从父项到子项断开继承链,并创建替换策略以根据需要添加用户。可以通过删除替换策略来恢复继承的策略及其用户。

"View the policies"和"modify the policies"组件级访问策略是此继承行为的一个例外。将用户添加到任一策略后,它们将添加到当前管理员列表中。他们不会覆盖更高级别的管理员。因此,仅显示特定于组件的管理员以查看"View the policies"和"modify the policies"访问策略。

你无法修改继承策略上的users/groups。只能在父策略或覆盖策略中添加或删除用户和租户。

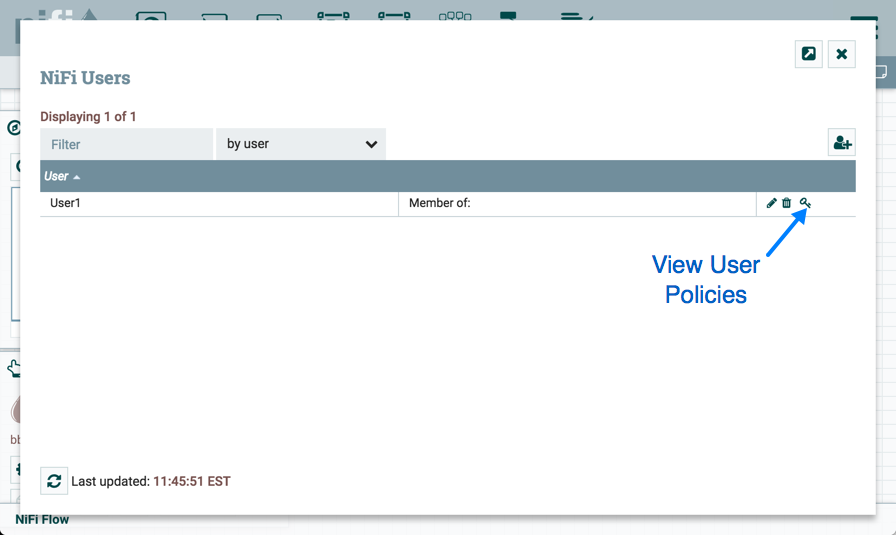

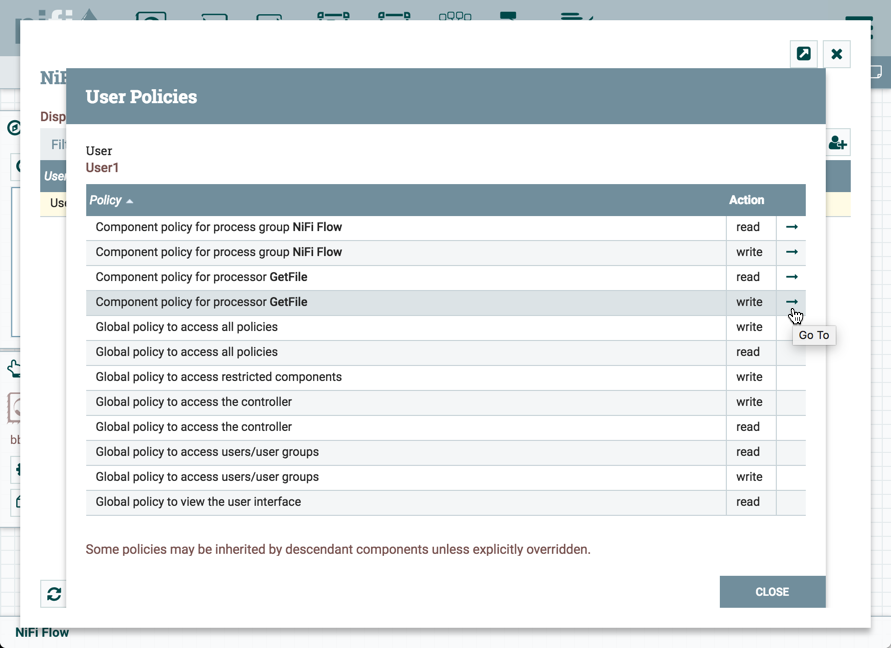

查看用户策略

在UI中,从全局菜单中选择"Users"。这将打开NiFi用户对话框。

选择"View User Policies"图标(![]() )。

)。

用户策略窗口显示已为所选用户设置的全局和组件级策略。选择"Go To"图标(![]() 以导航到画布中的该组件。

以导航到画布中的该组件。

访问策略配置示例

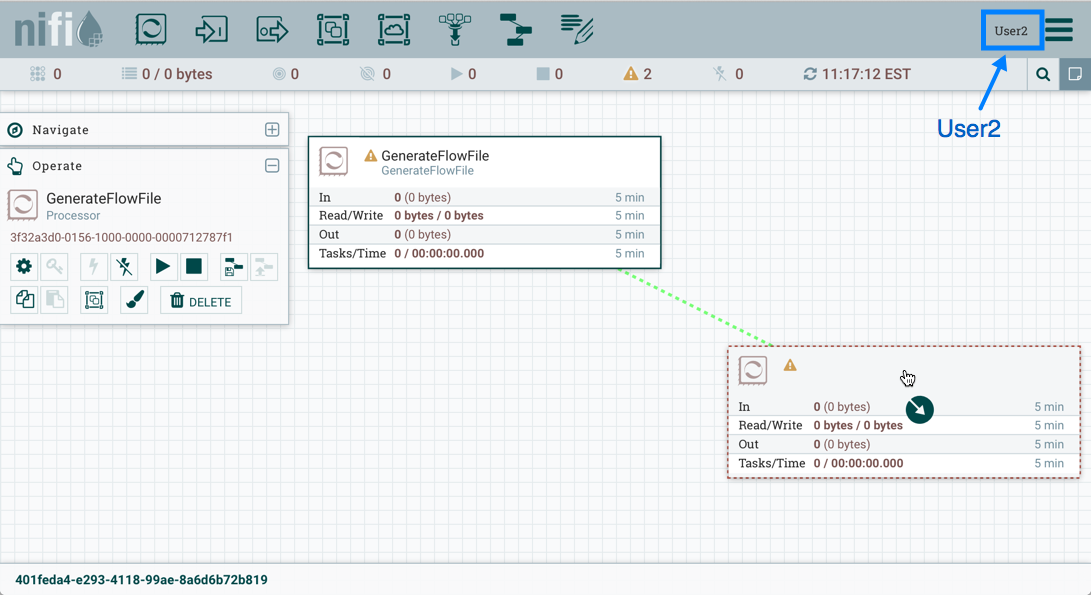

了解如何创建和应用访问策略的最有效方法是介绍一些常见示例。以下方案假定User1是管理员,而User2是新添加的用户,仅具有对UI的访问权限。

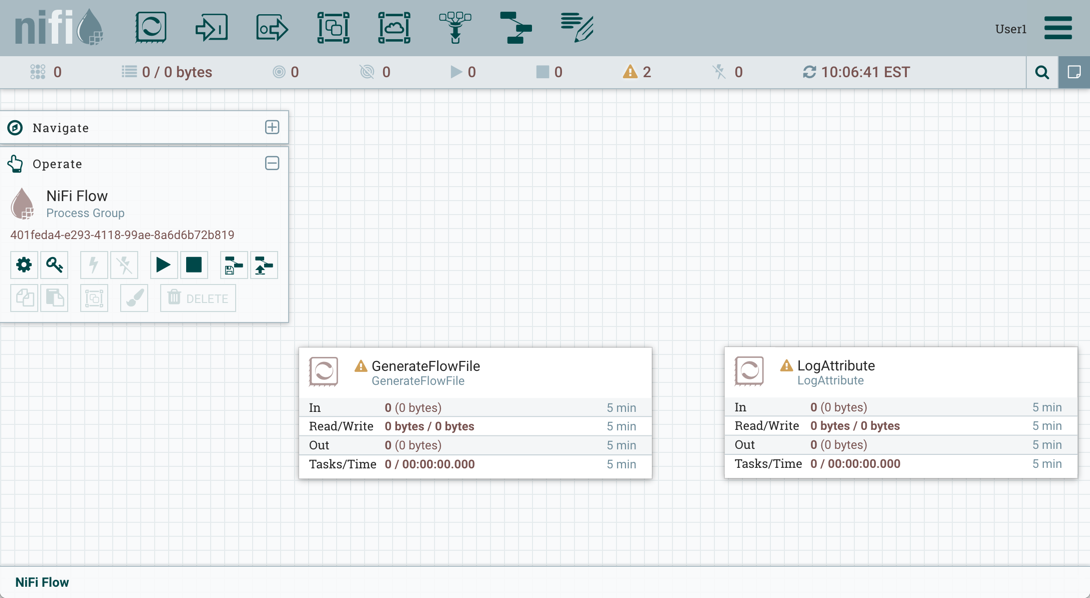

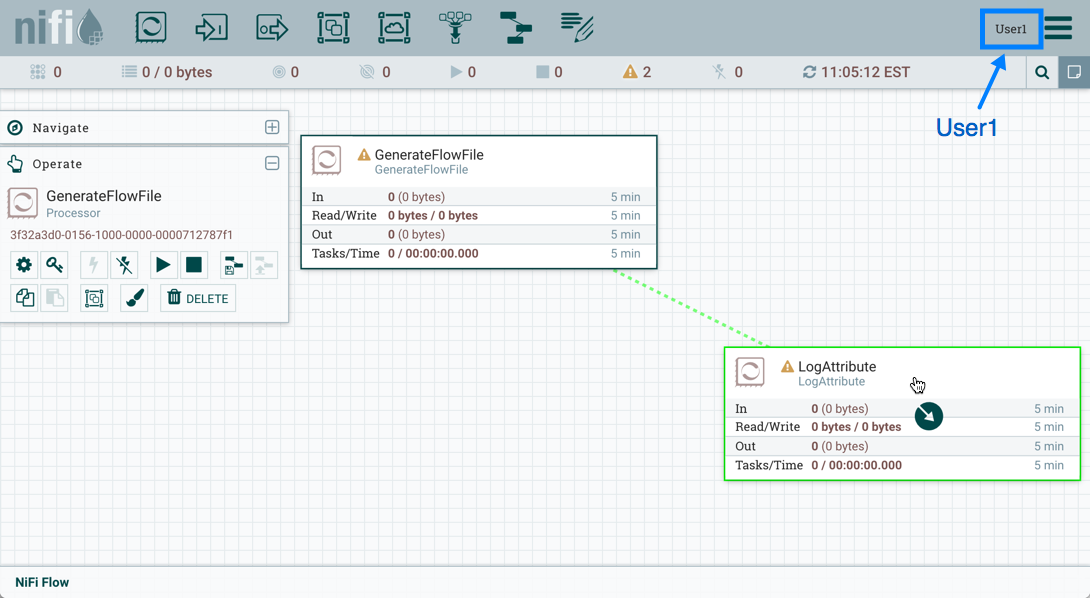

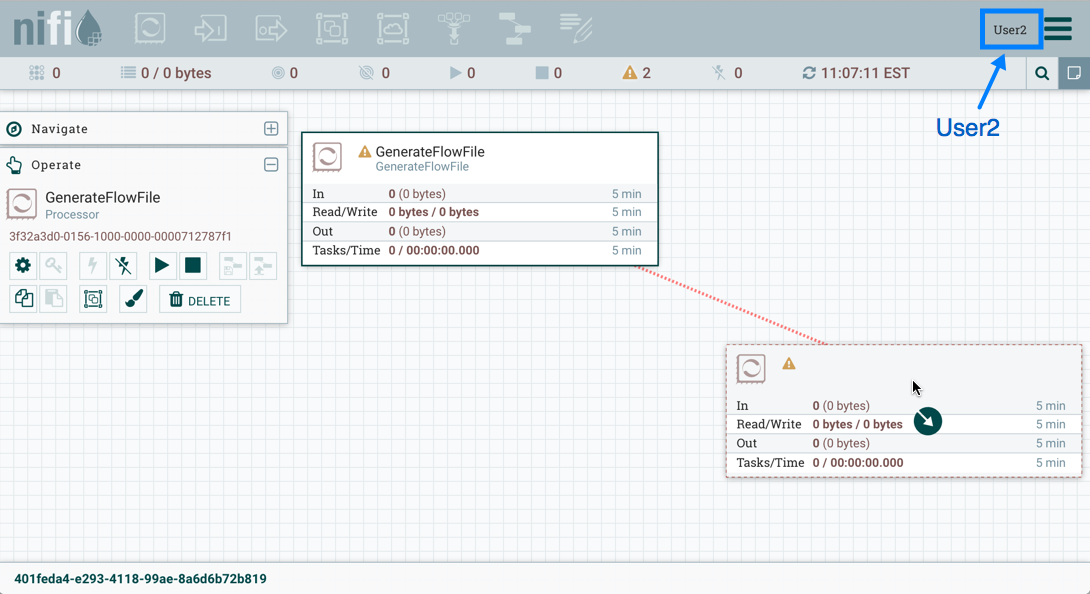

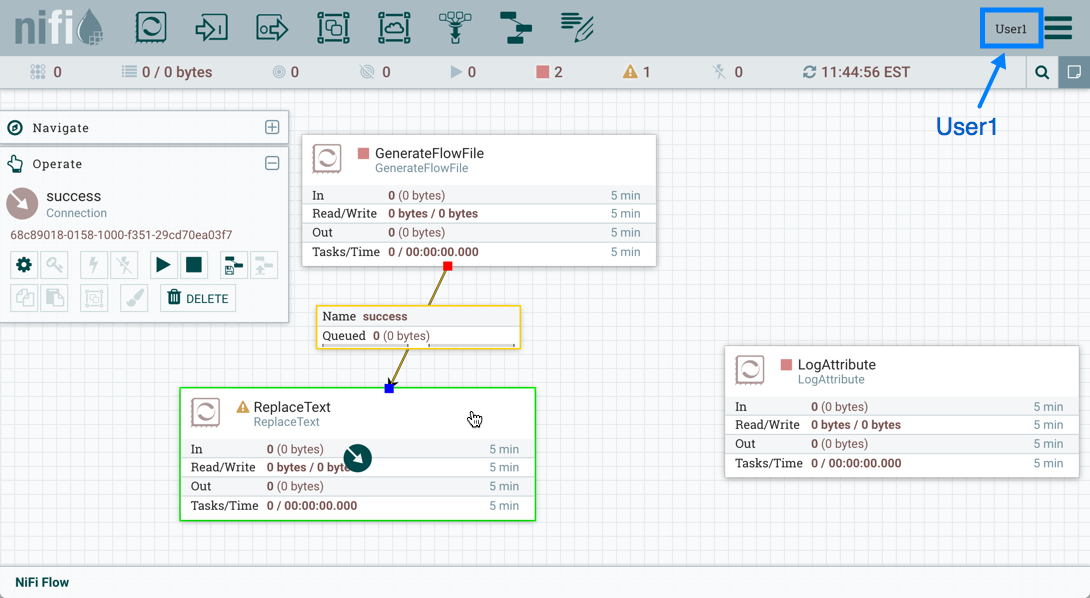

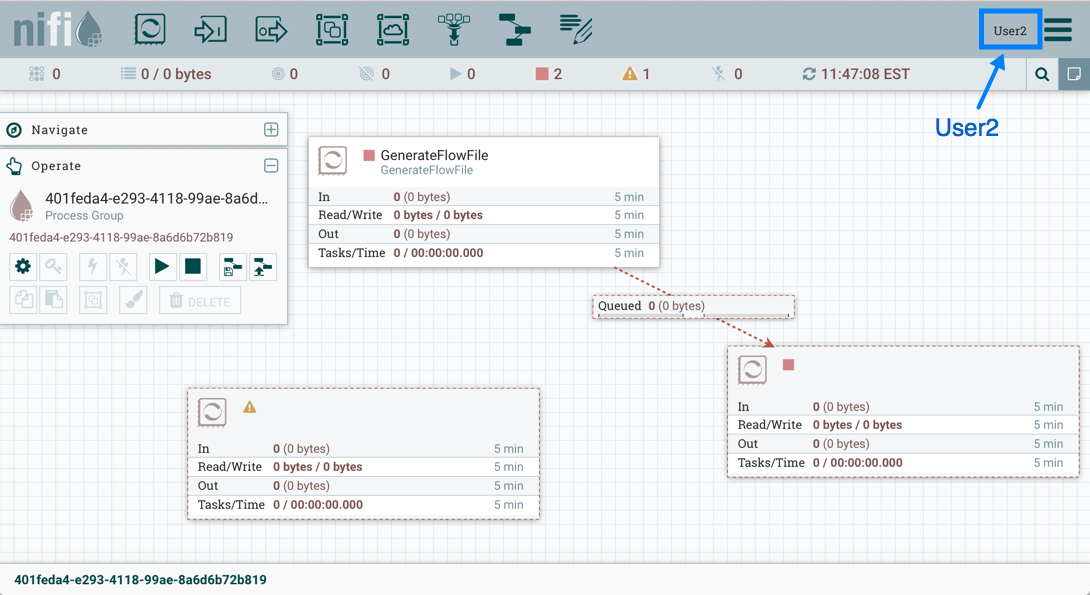

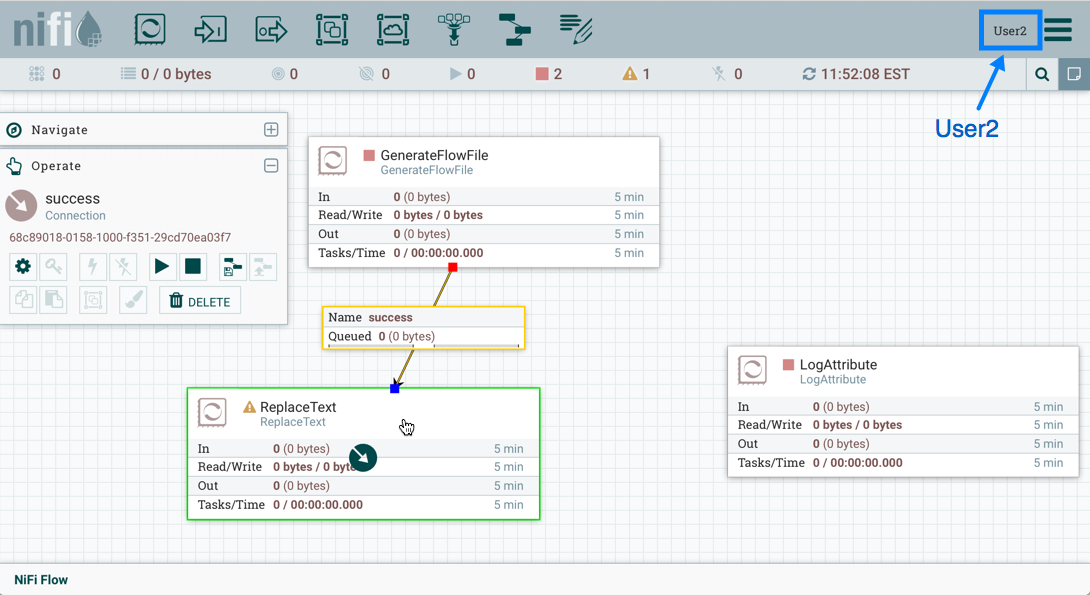

让我们从画布上的两个处理器开始作为我们的起点:GenerateFlowFile和LogAttribute。

User1可以向数据流添加组件,并能够移动,编辑和连接所有处理器。User1可以看到根进程组和处理器的详细信息和属性。

User1希望保持其对数据流及其组件的当前权限。

User2无法将组件添加到数据流或移动,编辑或连接组件。User2将隐藏根进程组和处理器的详细信息和属性。

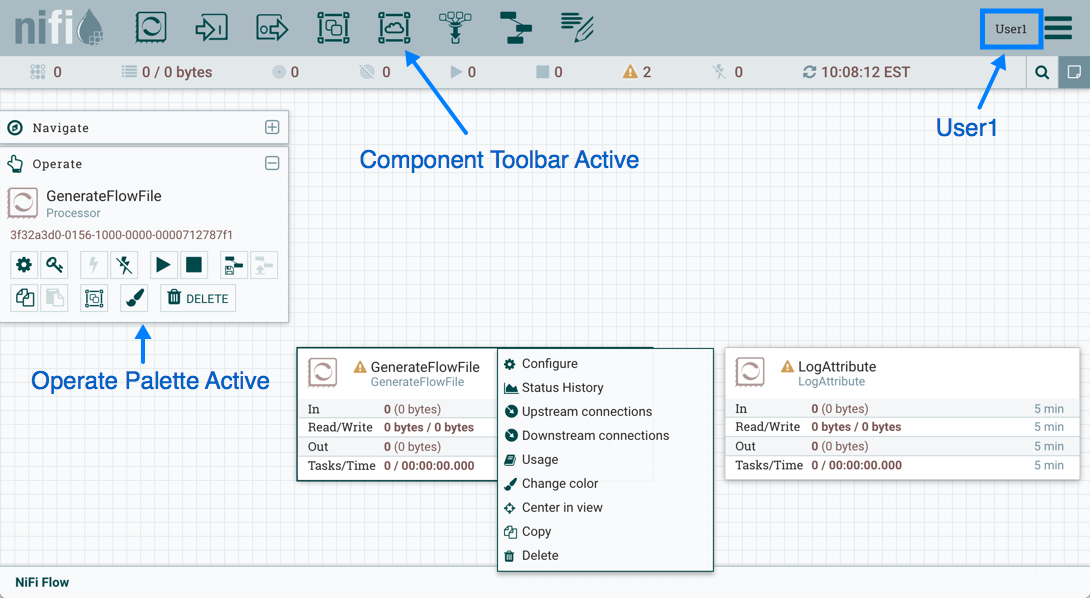

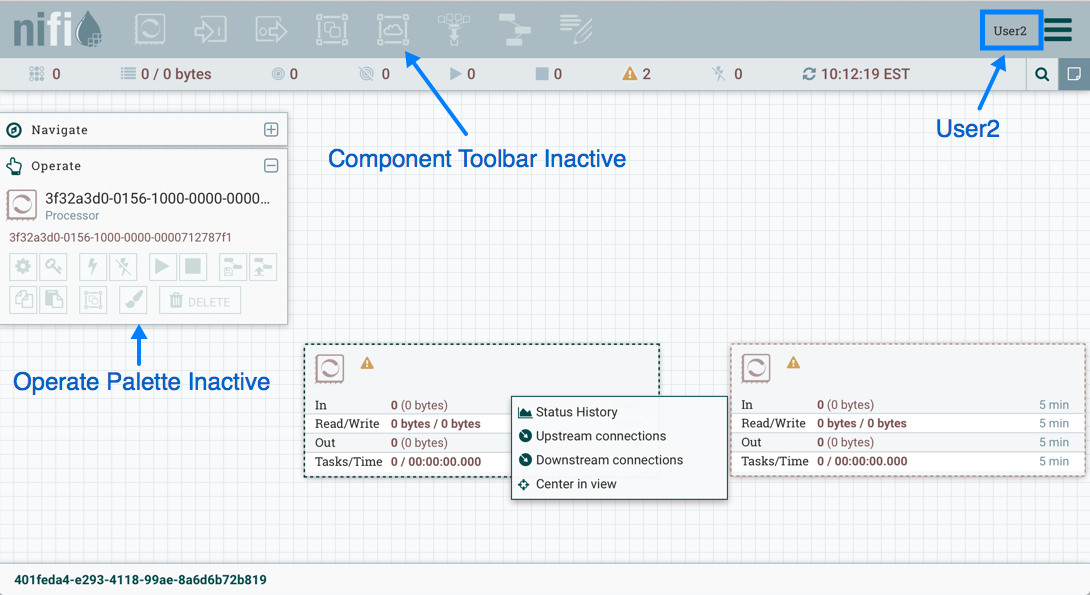

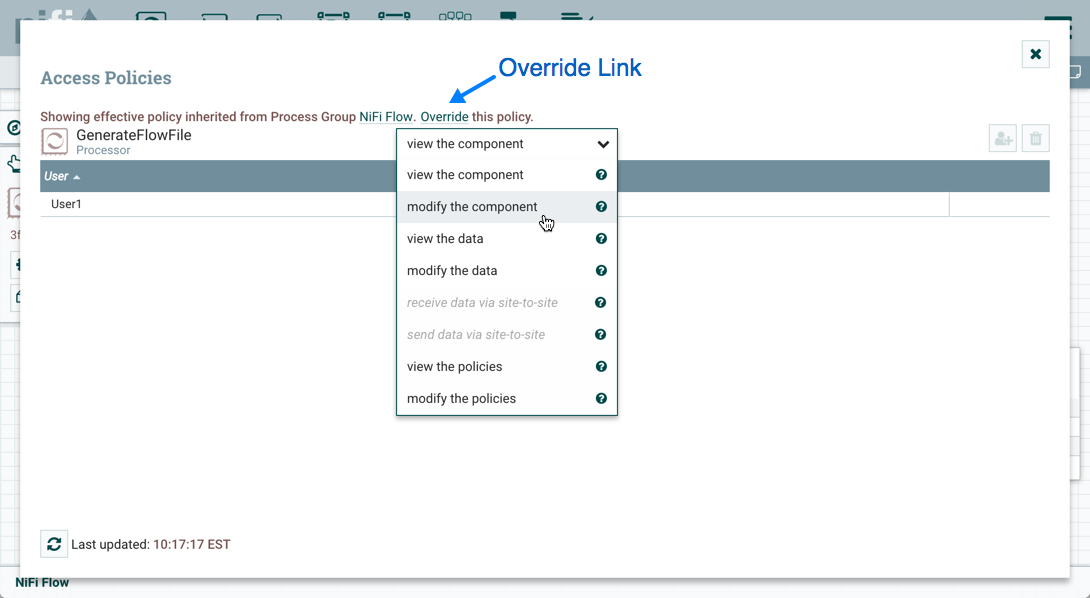

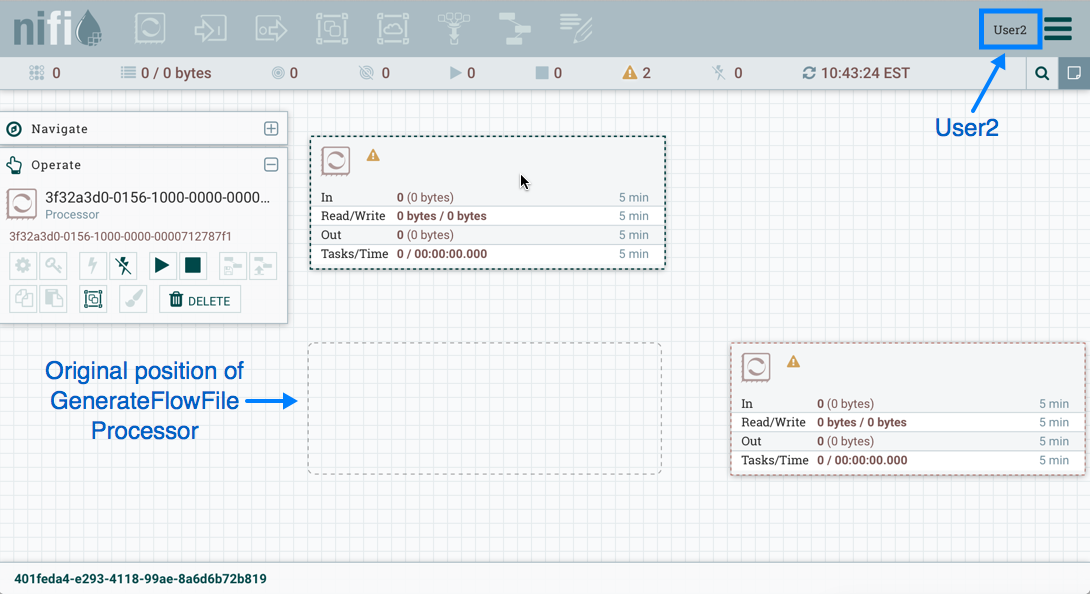

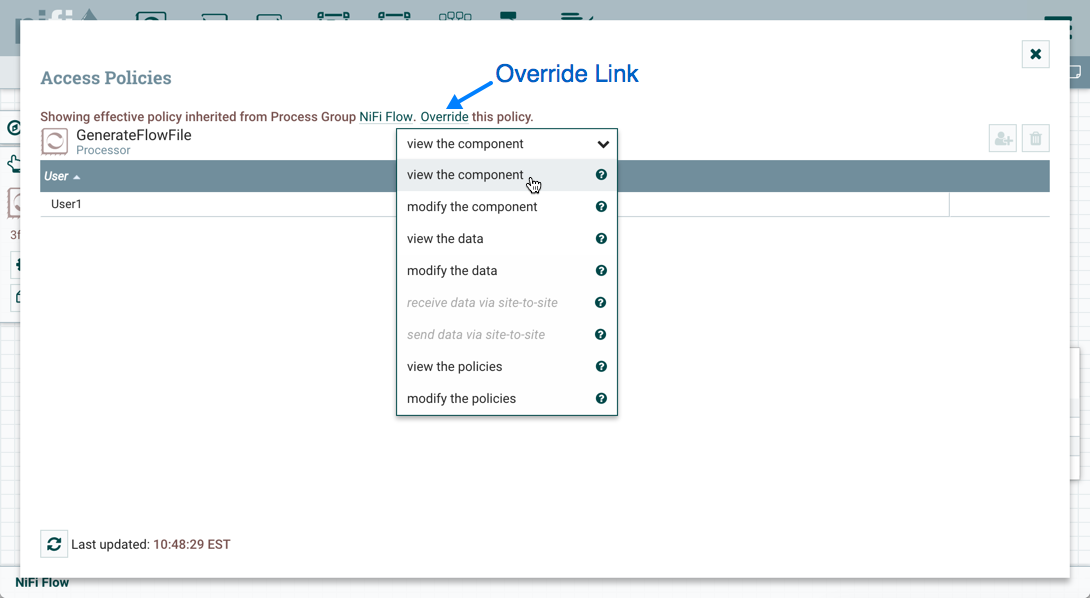

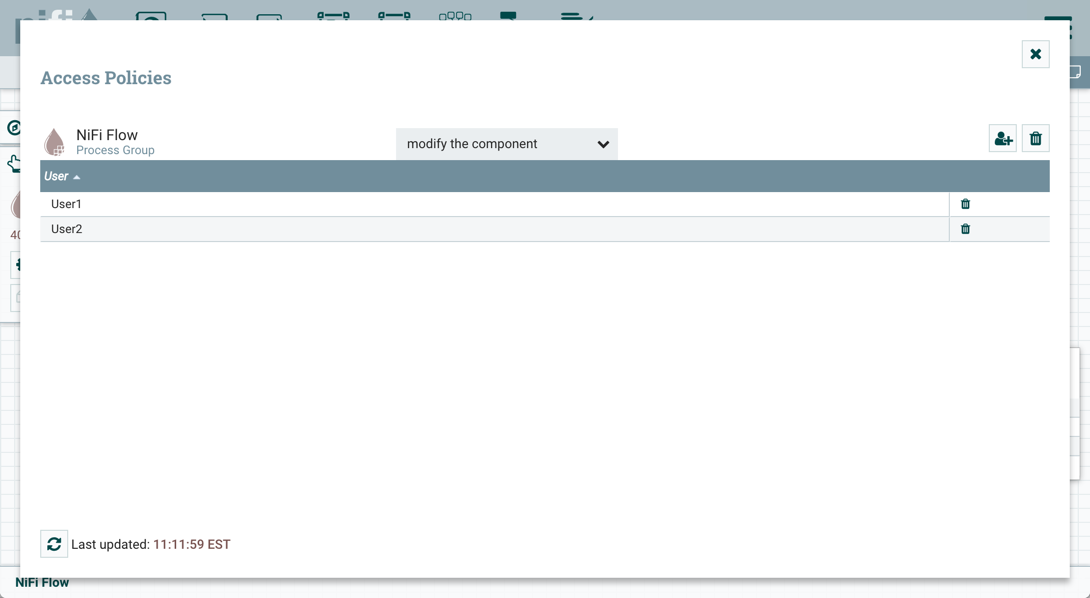

移动处理器

为了允许User2在数据流中移动GenerateFlowFile处理器而仅移动该处理器,User1执行以下步骤:

选择GenerateFlowFile处理器以使其突出显示。

从操作选项板中选择访问策略图标(

),然后打开访问策略对话框。

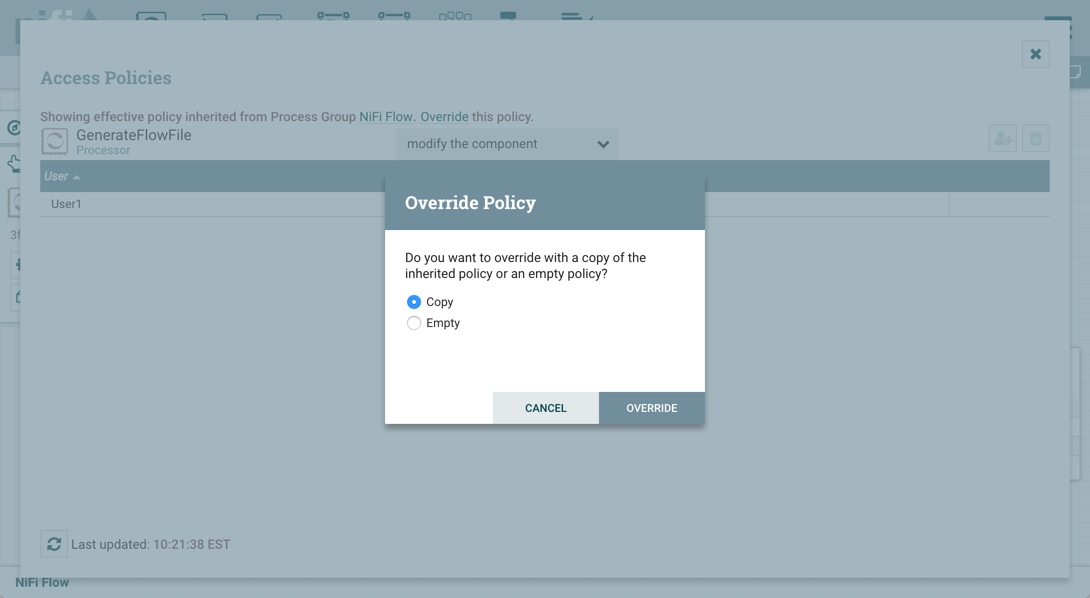

),然后打开访问策略对话框。从策略下拉列表中选择修改组件。处理器(子)上当前存在的修改组件策略是从User1具有权限的根进程组(父)继承的修改组件策略。

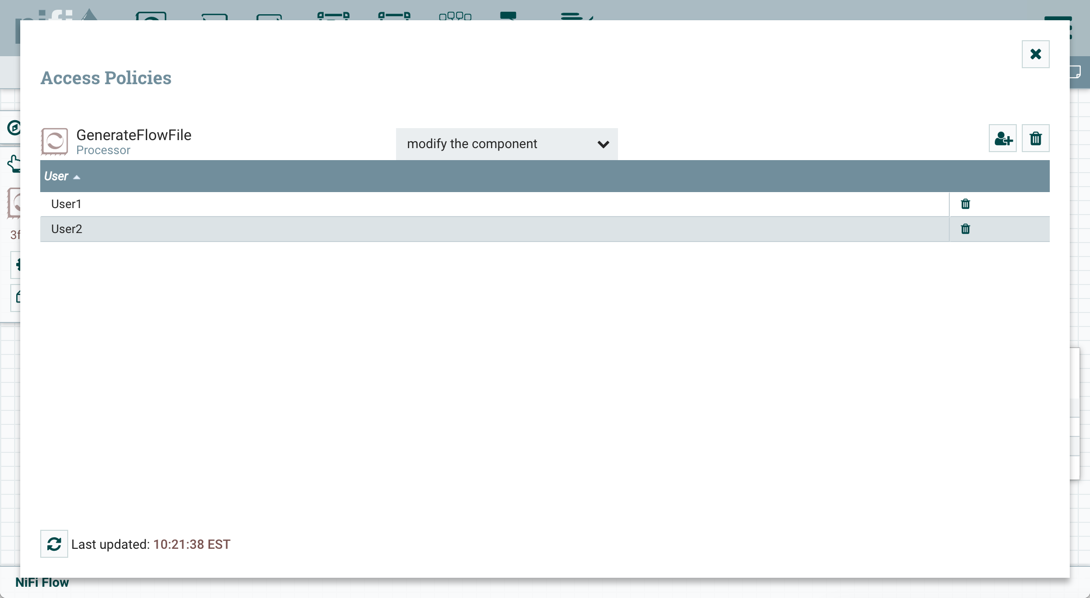

在策略继承消息中选择"覆盖"链接。创建替换策略时,你可以选择使用继承策略的副本或空策略覆盖。选择"覆盖"按钮以创建副本。

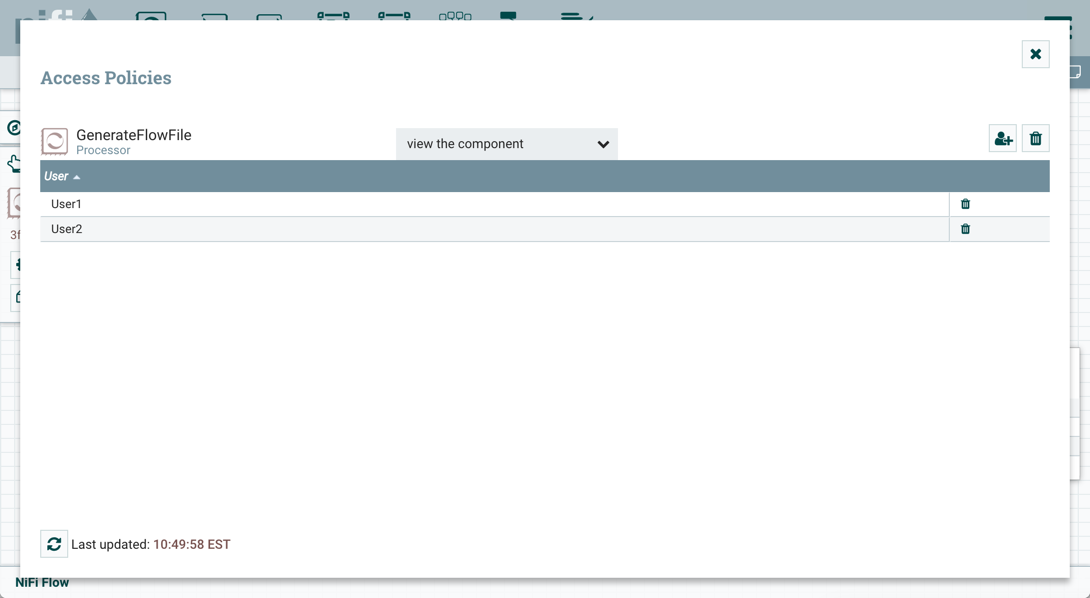

在创建的替换策略上,选择添加用户图标(

)。在用户标识字段中查找或输入User2,然后选择确定。通过这些更改,User1可以在画布上移动两个处理器。User2现在可以移动GenerateFlowFile处理器,但无法移动LogAttribute处理器。

)。在用户标识字段中查找或输入User2,然后选择确定。通过这些更改,User1可以在画布上移动两个处理器。User2现在可以移动GenerateFlowFile处理器,但无法移动LogAttribute处理器。

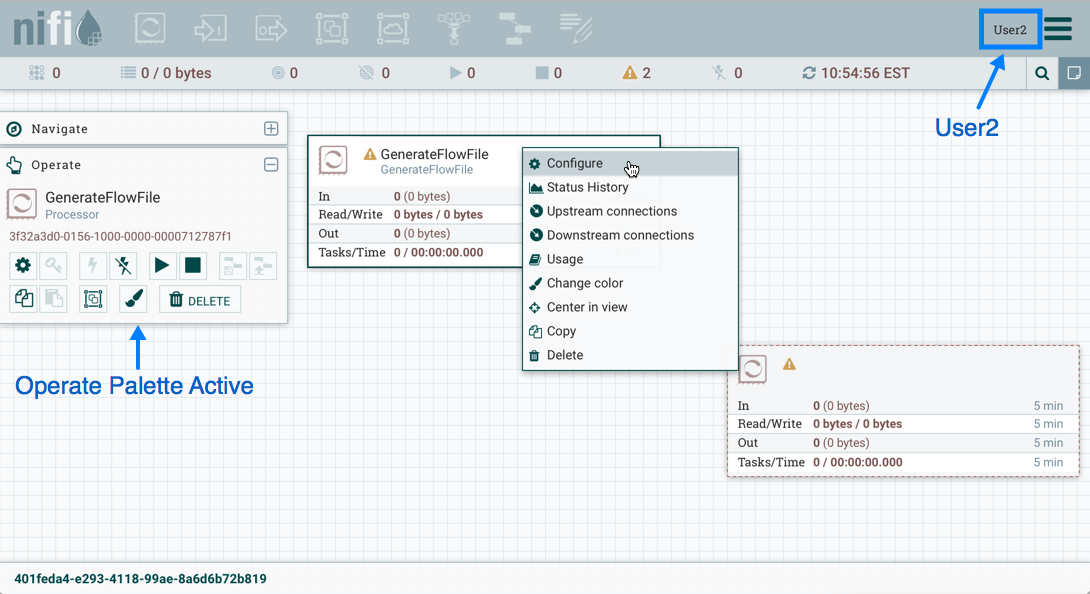

编辑处理器

在上面的移动处理器示例中,User2被添加到GenerateFlowFile的修改组件策略中。如果无法查看处理器属性,User2将无法修改处理器的配置。为了编辑组件,用户必须同时处于查看组件和修改组件策略。为实现此目的,User1执行以下步骤:

选择GenerateFlowFile处理器。

从操作选项板中选择访问策略图标(

),然后打开访问策略对话框。

),然后打开访问策略对话框。从策略下拉列表中选择查看组件。组件当前存在于处理器(子)上的策略视图是查看组件策略继承自User1具有权限的根进程组(父组件) 。

)

)在策略继承消息中选择覆盖链接,保留复制策略的默认值并选择覆盖按钮。

在创建的覆盖策略上,选择"添加用户"图标(

)。在用户标识字段中查找或输入User2,然后选择确定。通过这些更改,User1可以在画布上查看和编辑处理器。User2现在可以查看和编辑GenerateFlowFile处理器。

)。在用户标识字段中查找或输入User2,然后选择确定。通过这些更改,User1可以在画布上查看和编辑处理器。User2现在可以查看和编辑GenerateFlowFile处理器。

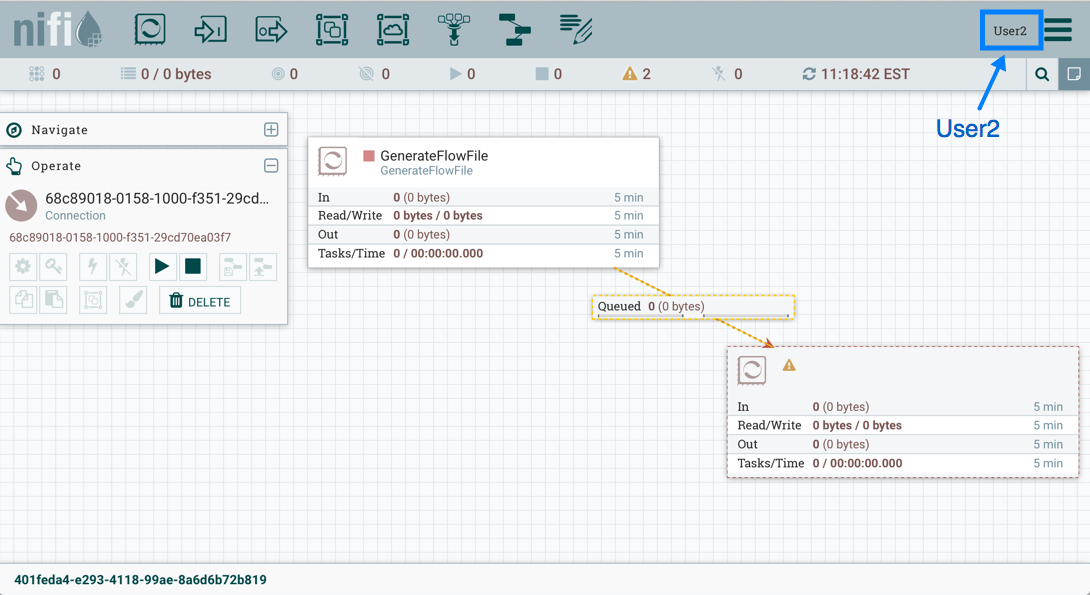

创建连接

通过前面两个示例中讨论的配置访问策略,User1能够将GenerateFlowFile连接到LogAttribute:

User2无法建立连接::

这是因为:

User2对进程组没有修改权限。

即使User2具有查看和修改对源组件(GenerateFlowFile)的访问权限,User2也没有对目标组件(LogAttribute)的访问策略。

允许User2将GenerateFlowFile连接到LogAttribute,如User1:

选择根进程组。操作选项板将更新根进程组的详细信息。

从操作选项板中选择访问策略图标(

),然后打开访问策略对话框。

),然后打开访问策略对话框。从策略下拉列表中选择修改组件。

选择添加用户图标(

)。找到或输入User2并选择确定。

)。找到或输入User2并选择确定。

通过将User2添加到进程组上的修改组件策略,User2将通过策略继承添加到LogAttribute处理器上的修改组件策略。要确认这一点,请突出显示LogAttribute处理器,然后从Operate面板中选择Access Policies图标(![]() ):

):

通过这些更改,User2现在可以将GenerateFlowFile处理器连接到LogAttribute处理器。

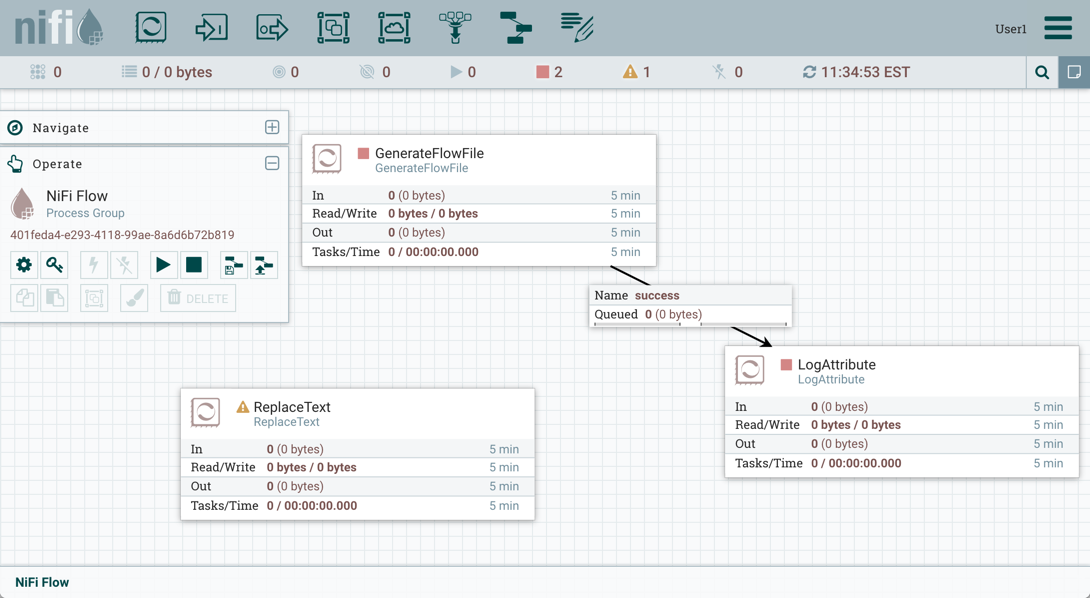

编辑连接

假设User1或User2将ReplaceText处理器添加到根进程组:

User1可以选择并更改现有连接(在GenerateFlowFile和LogAttribute之间),现在将GenerateFlowFile连接到ReplaceText:

用户2无法执行此操作。

允许User2将GenerateFlowFile连接到ReplaceText,如User1:

选择根进程组。操作选项板将更新根进程组的详细信息。

选择访问策略图标(

)。

)。从策略下拉列表中选择查看组件。

选择添加用户图标(

)。找到或输入User2并选择确定。

)。找到或输入User2并选择确定。

要添加到进程组的视图和修改策略,User2现在可以将GenerateFlowFile处理器连接到ReplaceText处理器。

加密配置

本节概述了NiFi加密和解密数据的功能。EncryptContent处理器允许加密和解密数据,这些数据既包含在NiFi内部,也包含在外部系统(如openssl其他数据源和消费者)中。

密钥派生函数

密钥导出函数(KDF)是将人类可读信息(通常是密码或其他秘密信息)转换为适合于数据保护的加密密钥的机制。有关详细信息,请阅读关键导出函数的Wikipedia条目。目前,KDF由CipherProvider实现提取并返回Cipher用于加密或解密的完全初始化的对象。由于使用了a CipherProviderFactory,KDF目前无法自定义。未来的增强功能包括在初始化时向KDF提供自定义成本参数的能力。作为解决方法,CipherProvider可以在构造函数中使用自定义成本参数初始化实例,但目前不支持CipherProviderFactory。以下是NiFi目前支持的KDF(主要EncryptContent用于基于密码的加密处理器(PBE))和相关说明:

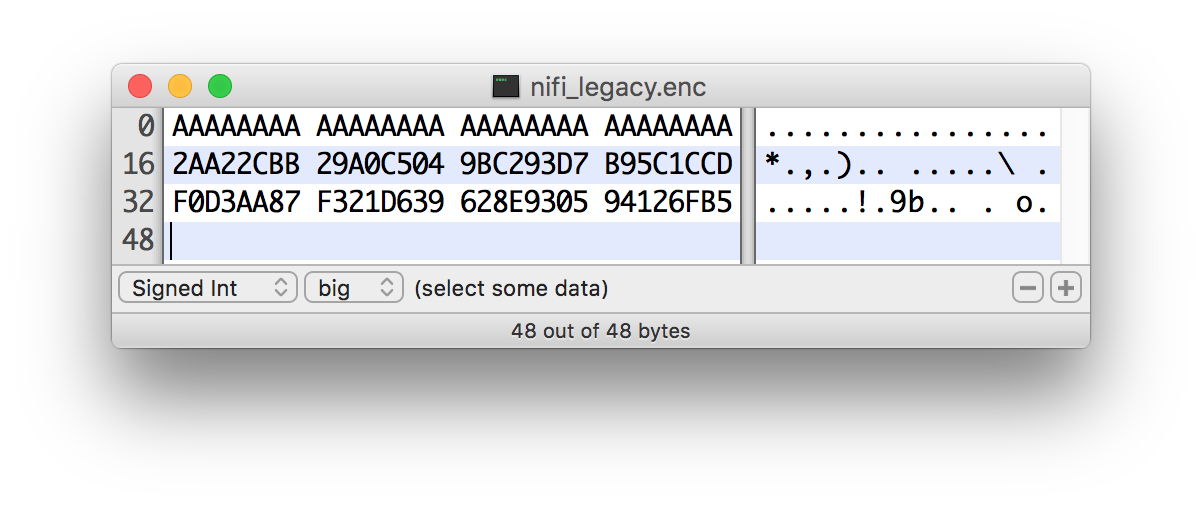

NiFi Legacy KDF

NiFi用于PBE的内部密钥推导的原始KDF,这是在密码和8或16字节随机盐的串联上的MD5摘要的1000次迭代(盐长度取决于所选择的密码块大小)。

从NiFi 0.5.0开始,该KDF已 弃用, 并且仅应用于向后兼容以解密先前由传统版本的NiFi加密的数据。

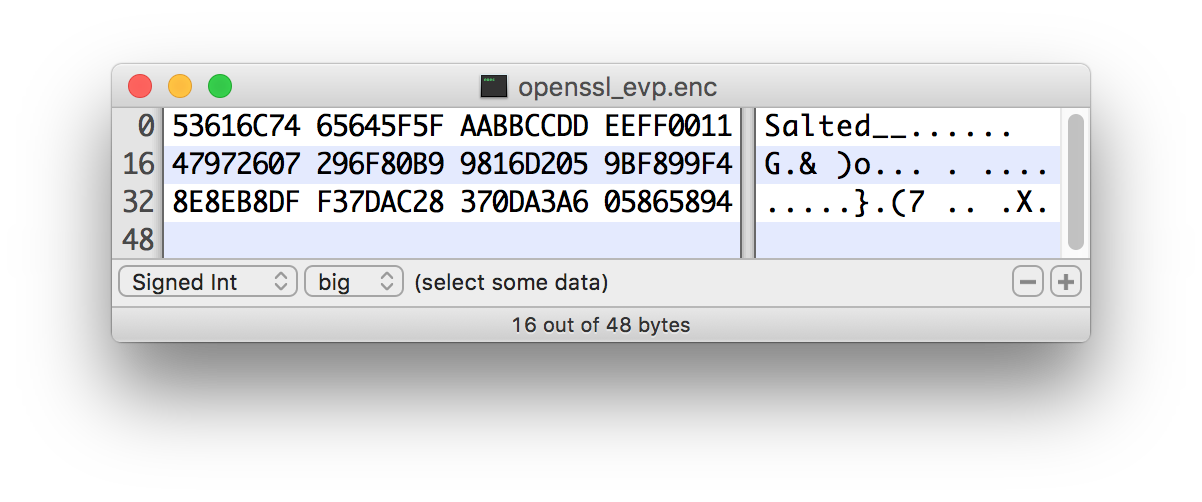

OpenSSL PKCS#5 v1.5 EVP_BytesToKey

该KDF在v0.4.0中添加。

此KDF用于与使用OpenSSL的默认PBE加密的数据兼容,称为

EVP_BytesToKey。这是MD5在密码和8字节随机ASCII盐的串联上的单次迭代。OpenSSL建议使用PBKDF2密钥派生,但不公开命令行工具所需的库方法,因此该KDF仍然是命令行加密的事实上的默认值。

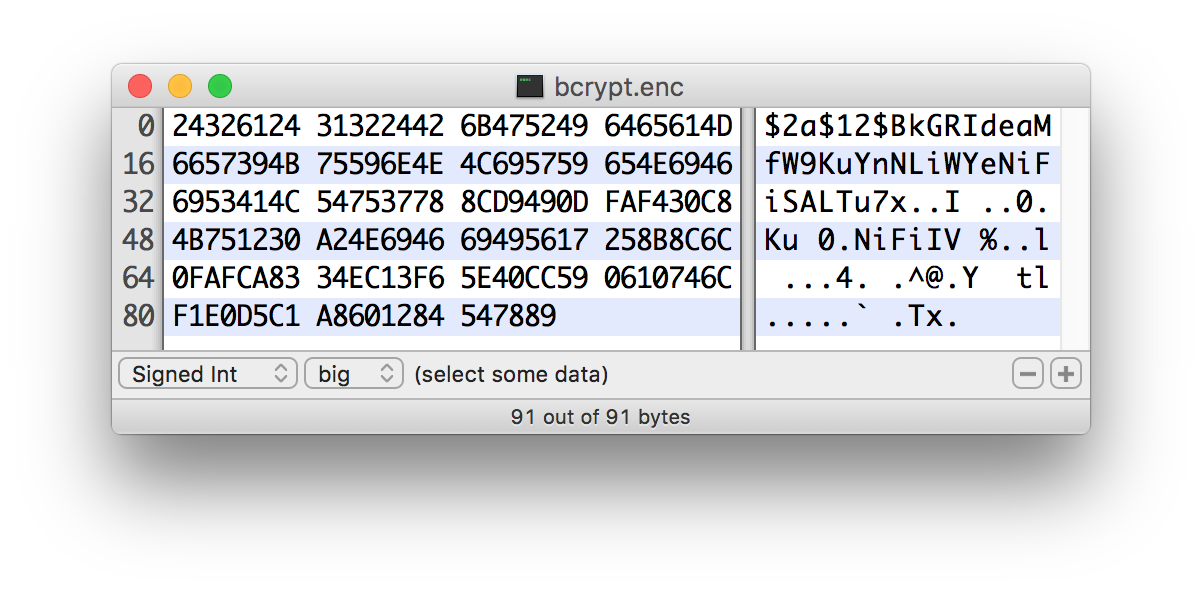

Bcrypt

该KDF在v0.5.0中添加。

Bcrypt是一种基于Blowfish密码的自适应函数。强烈建议使用此KDF,因为它会自动合并一个随机的16字节盐,可配置的成本参数(或"工作因素"),并且可以通过要求访问"大"来使用GPGPU(在内核之间共享内存)来抵御暴力攻击。密钥推导期间的内存块。它对FPGA暴力攻击的抵抗力较弱,门阵列可以访问各个嵌入式RAM块。

由于Bcrypt派生密钥的长度始终为184位,因此将完整输出提供给

SHA-512摘要并截断为所需的密钥长度。这为格式化输入提供了雪崩效应的好处。建议的最小工作因数是12(2 12个密钥派生轮次)(截至2016年2 月 1 日的商品硬件),应增加到合法系统遇到有害延迟的阈值(参见下面的时间表或用于

BcryptCipherProviderGroovyTest#testDefaultConstructorShouldProvideStrongWorkFactor()计算安全性)最小值)。盐格式是

$2a$10$ABCDEFGHIJKLMNOPQRSTUV。盐被划分,$三个部分如下:2a- 格式的版本。这里可以找到广泛的解释。NiFi目前2a用于内部产生的所有盐。10- 工作因素。这实际上是log 2值,因此在这种情况下总迭代次数将是2 10。ABCDEFGHIJKLMNOPQRSTUV- 22个字符,Base64编码,未填充,原盐值。这解码为密钥派生中使用的16字节盐。

Scrypt

该KDF在v0.5.0中添加。

Scrypt是为响应而设计的自适应功能

bcrypt。建议使用此KDF,因为它需要相对大量的内存用于每个派生,从而抵抗硬件暴力攻击。建议的最低成本是

N= 2 14,r= 8,p= 1(截至2016年2 月 1日的商品硬件),应增加到合法系统遇到有害延迟的阈值(参见下面的时间表或用于ScryptCipherProviderGroovyTest#testDefaultConstructorShouldProvideStrongParameters()计算安全性)最小值)。盐格式是

$s0$e0101$ABCDEFGHIJKLMNOPQRSTUV。盐被划分,$三个部分如下:s0- 格式的版本。NiFi目前s0用于内部产生的所有盐。e0101- 成本参数。这实际上是一个十六进制编码N,r,p使用偏移。这可以使用Scrypt#encodeParams()和形成/解析Scrypt#parseParameters()。- 一些外部库以形式编码

N,r并p单独编码$400$1$1$。可以使用实用方法ScryptCipherProvider#translateSalt()将外部表单转换为内部表单。

- 一些外部库以形式编码

ABCDEFGHIJKLMNOPQRSTUV- 12-44字符,Base64编码,未填充,原盐值。这解码为密钥派生中使用的8-32字节的盐。

PBKDF2

该KDF在v0.5.0中添加。

基于密码的密钥推导功能2是一种自适应推导功能,它使用内部伪随机函数(PRF)并通过密码和盐(至少16字节)多次迭代。

PRF建议为

HMAC/SHA-256或HMAC/SHA-512。HMAC加密散列函数的使用减轻了长度扩展攻击。建议的最小迭代次数为160,000(截至2016年2月1日的商品硬件)。这个数字应该每两年增加一倍(见下面的时间表或

PBKDF2CipherProviderGroovyTest#testDefaultConstructorShouldProvideStrongIterationCount()用来计算安全最小值)。这个KDF不是内存很难(可以用商用硬件进行大规模并行化),但仍然建议NIST SP 800-132(PDF)和许多密码学家(当使用适当的迭代计数和HMAC加密散列函数时)。

None

该KDF在v0.5.0中添加。

该KDF不对输入执行操作,并且是用于指示向密码提供原始密钥的标记。密钥必须以十六进制编码提供,并且对于关联的密码/算法具有有效长度。

其他资源

盐和IV编码

最初,EncryptContent处理器有一种从用户提供的密码导出加密密钥的方法。现在NiFiLegacy有效地将其称为模式MD5 digest, 1000 iterations。在v0.4.0中,添加了另一种导出密钥的方法,OpenSSL PKCS#5 v1.5 EVP_BytesToKey以便与使用openssl命令行工具在NiFi外部加密的内容兼容。这两个密钥派生函数(KDF)都具有硬编码的摘要函数和迭代计数,并且salt格式也是硬编码的。使用v0.5.0,引入了具有可变迭代计数,工作因子和盐格式的附加KDF。另外,_原始密钥加密_还介绍了。这需要将任意盐和初始化矢量(IV)编码到密码流中的能力,以便由NiFi或后续系统恢复以解密这些消息。

对于现有的KDF,salt格式没有改变。

NiFi Legacy

输入的前8或16个字节是salt。盐长度基于所选算法的密码块长度确定。如果无法确定密码块大小(例如使用流密码RC4),则使用默认值8字节。在解密时,盐被读入并与密码组合以导出加密密钥和IV。

OpenSSL PKCS#5 v1.5 EVP_BytesToKey

OpenSSL允许使用salted或unsalted密钥派生。_*无保留密钥派生是一种安全风险,不建议使用。*_如果存在salt,则输入的前8个字节为ASCII字符串"Salted __"(0x53 61 6C 74 65 64 5F 5F),接下来的8个字节为ASCII编码的salt。在解密时,盐被读入并与密码组合以导出加密密钥和IV。如果没有salt标头,则整个输入被认为是密文。

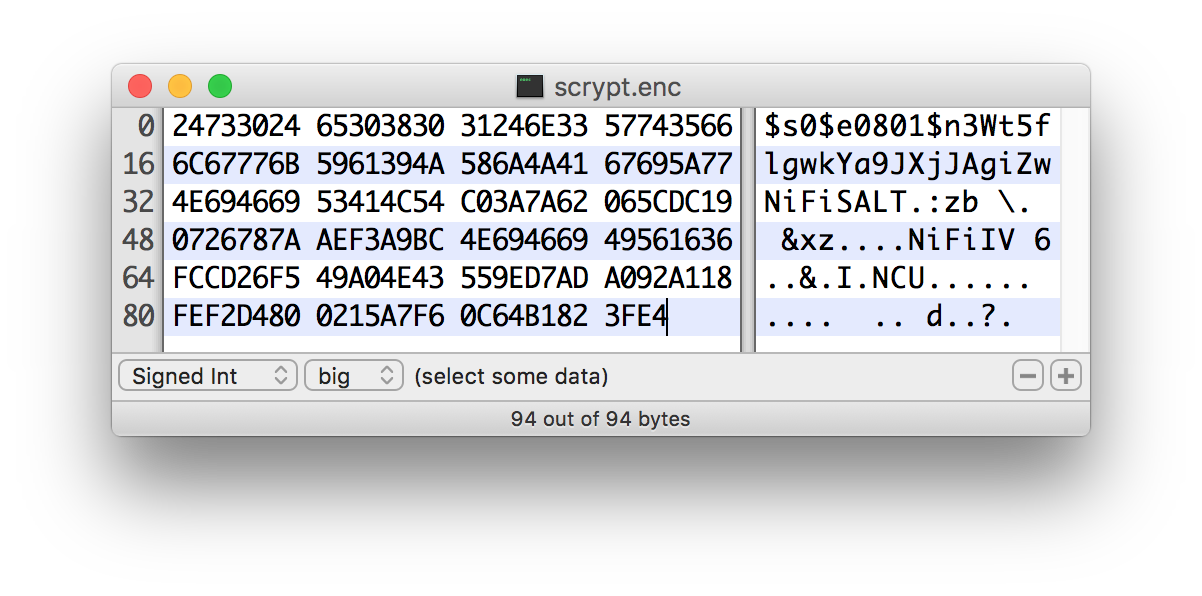

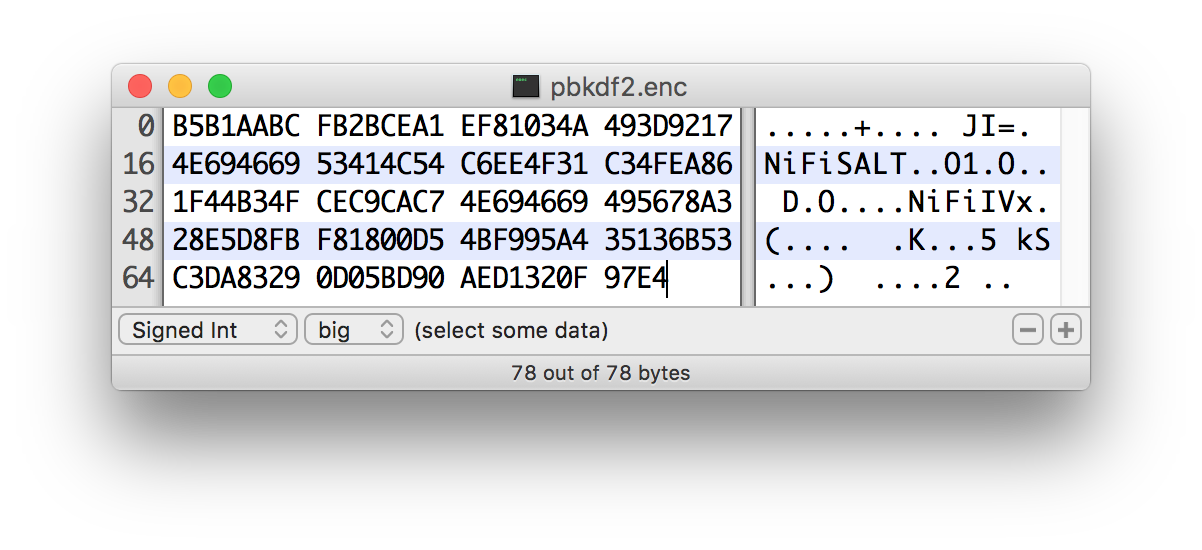

对于新的KDF,每个都允许非确定性IV,IV必须与密文一起存储。这不是一个漏洞,因为IV不需要保密,而只是对于使用相同密钥加密的消息是唯一的,以减少加密攻击的成功。对于这些KDF,输出包括盐,然后是盐分隔符,UTF-8字符串"NiFiSALT"(0x4E 69 46 69 53 41 4C 54)然后是IV,接着是IV分隔符,UTF-8字符串"NiFiIV"(0x4E 69 46 69 49 56),然后是密文。

Bcrypt,Scrypt,PBKDF2

EncryptContent处理器允许加密和解密数据,这些数据既包含在NiFi内部,也包含在外部系统(如openssl其他数据源和消费者)中。

Java密码术扩展(JCE)有限强度管辖政策

由于美国的出口法规,默认JVM 对其可用的加密操作的强度施加了限制。例如,AES操作128 bit keys默认限制为。虽然AES-128在加密方面是安全的,但这可能会产生意想不到的后果,特别是在基于密码的加密(PBE)上。

PBE是从_用户提供的秘密材料_(通常是密码)导出用于加密或解密的加密密钥的过程。不是人类记住(随机出现的)32或64个字符的十六进制字符串,而是使用密码或密码。

由于基础密钥长度检查,NiFi提供的许多PBE算法对密码长度施加了严格的限制。下表列出了具有有限加密强度的JVM上的最大密码长度。

| 算法 | 最大密码长度 |

|---|---|

PBEWITHMD5AND128BITAES-CBC-OPENSSL | 16 |

PBEWITHMD5AND192BITAES-CBC-OPENSSL | 16 |

PBEWITHMD5AND256BITAES-CBC-OPENSSL | 16 |

PBEWITHMD5ANDDES | 16 |

PBEWITHMD5ANDRC2 | 16 |

PBEWITHSHA1ANDRC2 | 16 |

PBEWITHSHA1ANDDES | 16 |

PBEWITHSHAAND128BITAES-CBC-BC | 7 |

PBEWITHSHAAND192BITAES-CBC-BC | 7 |

PBEWITHSHAAND256BITAES-CBC-BC | 7 |

PBEWITHSHAAND40BITRC2-CBC | 7 |

PBEWITHSHAAND128BITRC2-CBC | 7 |

PBEWITHSHAAND40BITRC4 | 7 |

PBEWITHSHAAND128BITRC4 | 7 |

PBEWITHSHA256AND128BITAES-CBC-BC | 7 |

PBEWITHSHA256AND192BITAES-CBC-BC | 7 |

PBEWITHSHA256AND256BITAES-CBC-BC | 7 |

PBEWITHSHAAND2-KEYTRIPLEDES-CBC | 7 |

PBEWITHSHAAND3-KEYTRIPLEDES-CBC | 7 |

PBEWITHSHAANDTWOFISH-CBC | 7 |

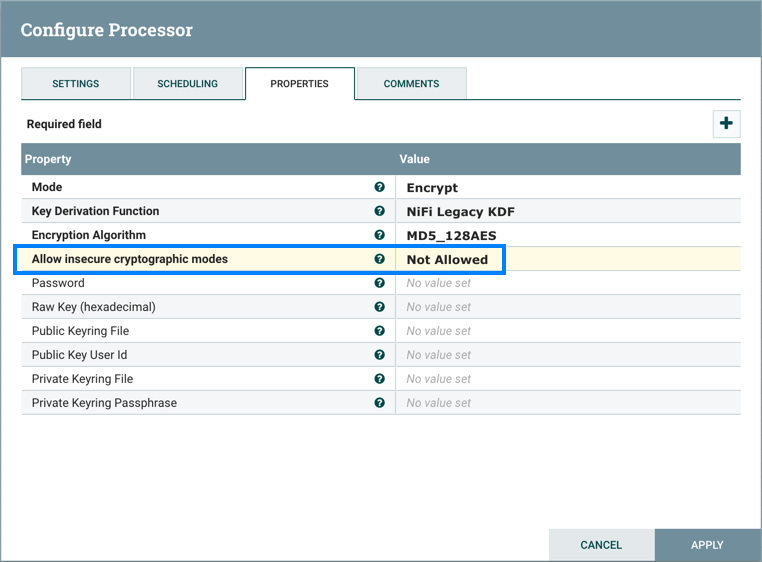

允许不安全的加密模式

默认情况下,处理器设置中的Allow Insecure Cryptographic Modes属性EncryptContent设置为not-allowed。这意味着如果提供的密码少于10字符,则会发生验证错误。10个字符是保守估计,不考虑完整熵计算,模式等。

在具有有限强度加密的JVM上,一些PBE算法将最大密码长度限制为7,在这种情况下,将无法提供"安全"密码。建议为JVM安装JCE Unlimited Strength Jurisdiction Policy文件以缓解此问题。

如果在无法安装无限强度策略的系统上,建议切换到支持更长密码的算法(参见上表)。

允许弱加密 如果它是不可能安装无限强度管辖的政策,该

Allow Weak Crypto设置可以改变allowed,但是这是_不_推荐的。更改此设置明确承认使用弱加密配置的固有风险。

最好是请求上游/下游系统切换到密钥加密或使用NiFi支持的"强" 密钥导出功能(KDF)。

配置文件中的加密密码

为了便于安全设置NiFi,你可以使用encrypt-config命令行实用程序加密NiFi在启动时在内存中解密的原始配置值。这种可扩展的保护方案透明地允许NiFi在操作中使用原始值,同时保护它们静止。将来,将集成硬件安全模块(HSM)和外部安全存储机制,但目前,AES加密提供程序是默认实现。

这是行为的改变; 在1.0之前,所有配置值都以明文形式存储在文件系统上。建议使用POSIX文件权限来限制对这些文件的未授权访问。

如果未执行管理员操作,则配置值保持未加密状态。

有关更多信息,请参阅NiFi工具包指南中的加密配置工具部分。

NiFi Toolkit Administrative Tools

除了tls-toolkit和之外encrypt-config,NiFi Toolkit还包含命令行实用程序,供管理员在独立和集群环境中支持NiFi维护。这些工具包括:

CLI - 该

cli工具使管理员能够与NiFi和NiFi Registry实例进行交互,以自动执行诸如部署版本化流程以及管理流程组和集群节点等任务。文件管理器(File Manager) - 该

file-manager工具使管理员能够从备份中备份,安装或恢复NiFi安装。流量分析器(Flow Analyzer) - 该

flow-analyzer工具生成一个报告,帮助管理员了解可以存储在给定流量的背压中的最大数据量。节点管理器(Node Manager ) - 该

node-manager工具使管理员能够对节点执行状态检查,以及从集群连接,断开连接或删除节点的功能。通知(Notify) - 该

notify工具使管理员能够将公告发送到NiFi UI。S2S - 该

s2s工具使管理员能够通过站点到站点将数据发送到NiFi流中或从中发送出来。

有关每个实用程序的详细信息,请参阅NiFi工具包指南。

集群配置

本节简要概述了NiFi集群以及如何设置基本集群的说明。在未来,我们希望提供涵盖NiFi集群架构的补充文档。

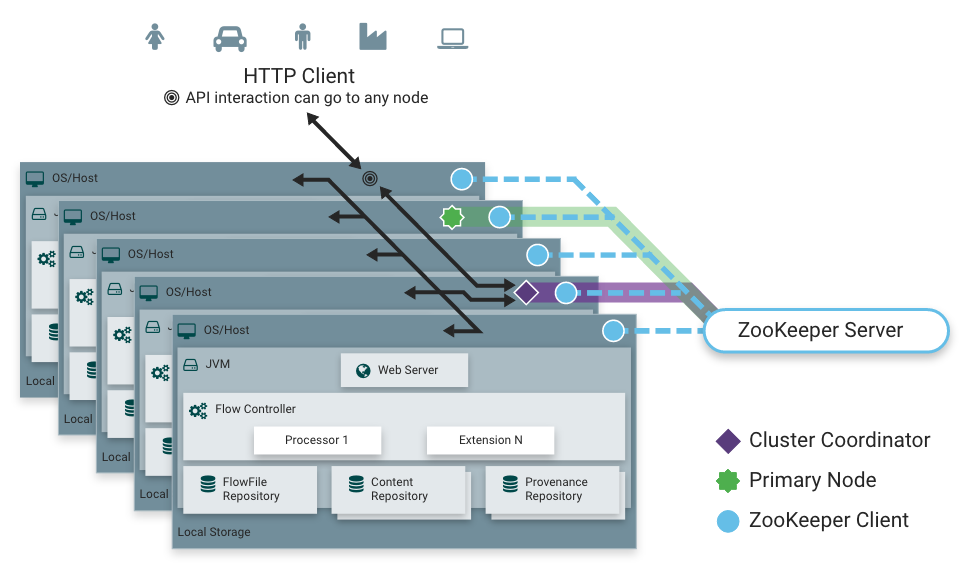

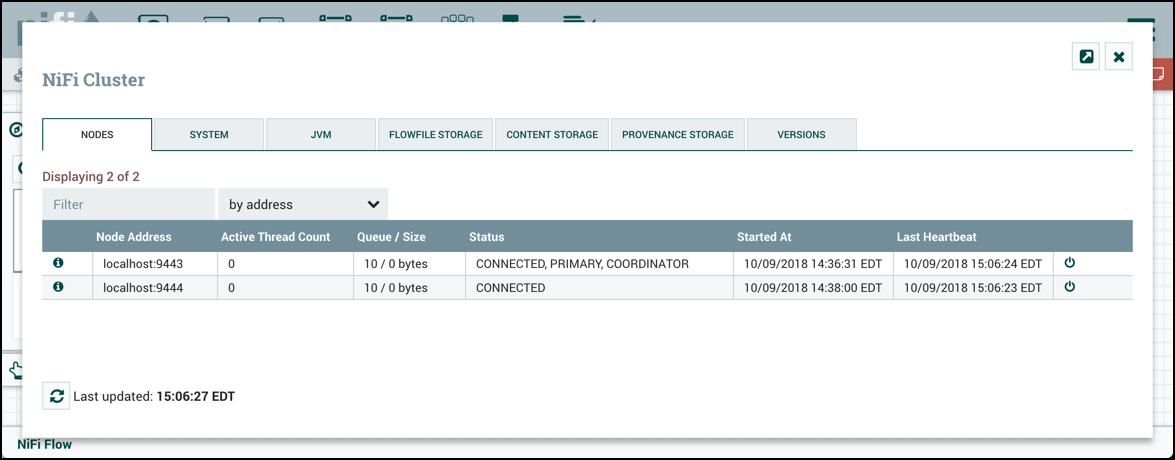

零主集群

NiFi采用Zero-Master Clustering范例。集群中的每个节点都对数据执行相同的任务,但每个节点都在不同的数据集上运行。其中一个节点自动选择(通过Apache ZooKeeper)作为集群协调器。然后,集群中的所有节点都会向此节点发送心跳/状态信息,并且此节点负责断开在一段时间内未报告任何心跳状态的节点。此外,当新节点选择加入集群时,新节点必须首先连接到当前选定的集群协调器,以获取最新的流。如果集群协调器确定允许该节点加入(基于其配置的防火墙文件),则将当前流提供给该节点,并且该节点能够加入集群,假设节点的流副本与集群协调器提供的副本匹配。如果节点的流配置版本与集群协调器的版本不同,则该节点将不会加入集群。

为什么集群?

NiFi管理员或DataFlow管理器(DFM)可能会发现在单个服务器上使用一个NiFi实例不足以处理他们拥有的数据量。因此,一种解决方案是在多个NiFi服务器上运行相同的数据流。但是,这会产生管理问题,因为每次DFM想要更改或更新数据流时,他们必须在每个服务器上进行这些更改,然后单独监视每个服务器。通过集群NiFi服务器,可以增加处理能力以及单个接口,通过该接口可以更改数据流并监控数据流。集群允许DFM仅进行一次更改,然后将更改复制到集群的所有节点。通过单一接口,DFM还可以监视所有节点的健康状况和状态。

术语

NiFi Clustering是独一无二的,有自己的术语。在设置集群之前了解以下术语非常重要:

NiFi集群协调器(NiFi Cluster Coordinator):NiFi集群协调器是NiFi集群中的节点,负责执行任务以管理集群中允许的节点,并为新加入的节点提供最新的流量。当DataFlow Manager管理集群中的数据流时,他们可以通过集群中任何节点的用户界面执行此操作。然后,所做的任何更改都将复制到集群中的所有节点。

节点(Nodes):每个集群由一个或多个节点组成。节点执行实际的数据处理。

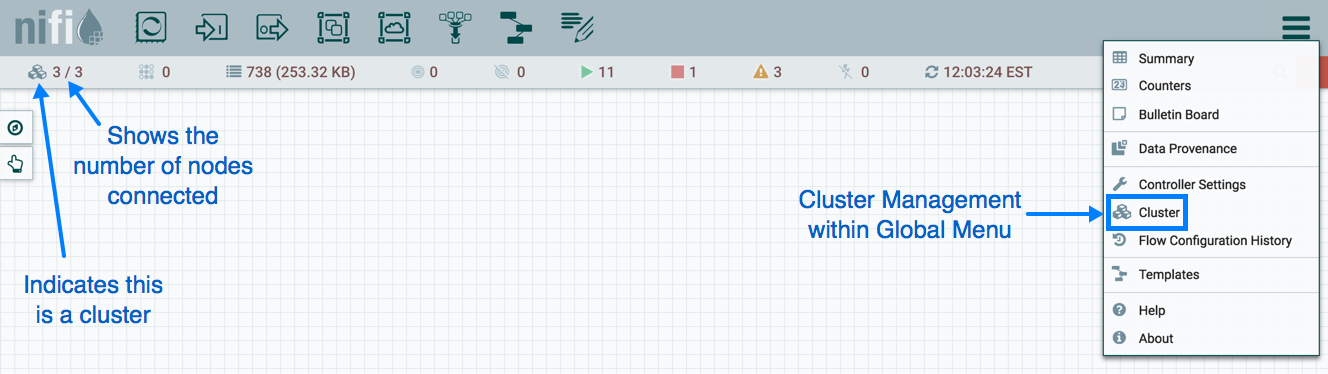

主节点(Primary Node):每个集群都有一个主节点。在此节点上,可以运行"隔离处理器"(见下文)。ZooKeeper用于自动选择主节点。如果该节点由于任何原因断开与集群的连接,将自动选择新的主节点。用户可以通过查看用户界面的"集群管理"页面来确定当前选择哪个节点作为主节点。

孤立的处理器:在NiFi集群中,相同的数据流在所有节点上运行。因此,流中的每个组件都在每个节点上运行。但是,可能存在DFM不希望每个处理器在每个节点上运行的情况。最常见的情况是使用的处理器使用不能很好扩展的协议与外部服务进行通信。例如,GetSFTP处理器从远程目录中提取。如果GetSFTP处理器在集群中的每个节点上运行并同时尝试从同一个远程目录中提取,则可能存在竞争条件。因此,DFM可以将主节点上的GetSFTP配置为独立运行,这意味着它仅在该节点上运行。通过适当的数据流配置,它可以提取数据并在集群中的其余节点之间对其进行负载平衡。请注意,虽然存在此功能,但仅使用独立的NiFi实例来提取数据并将其提供给集群也很常见。它仅取决于可用资源以及管理员决定配置集群的方式。

心跳:节点通过"心跳"将其健康状况和状态传达给当前选定的集群协调器,这使协调器知道它们仍然连接到集群并正常工作。默认情况下,节点每5秒发出一次心跳,如果集群协调器在40秒内没有从节点收到心跳,则由于"缺乏心跳"而断开节点。5秒设置可在_nifi.properties_文件中配置(请参阅集群公共属性)部分了解更多信息)。集群协调器断开节点的原因是协调器需要确保集群中的每个节点都处于同步状态,并且如果没有定期听到节点,协调器无法确定它是否仍与其余节点同步集群。如果在40秒后节点发送新的心跳,协调器将自动请求节点重新加入集群,以包括重新验证节点的流。一旦接收到心跳,由于心跳不足导致的断开连接和重新连接都会报告给用户界面中的DFM。

集群内的通信

如上所述,节点通过心跳与集群协调器通信。当选择集群协调器时,它会使用其连接信息更新Apache ZooKeeper中众所周知的ZNode,以便节点了解发送心跳的位置。如果其中一个节点发生故障,则集群中的其他节点将不会自动获取丢失节点的负载。DFM可以配置故障转移意外事件的数据流; 但是,这取决于数据流设计,并不会自动发生。

当DFM对数据流进行更改时,接收更改流的请求的节点会将这些更改传递给所有节点,并等待每个节点响应,表明它已对其本地流进行了更改。

管理节点

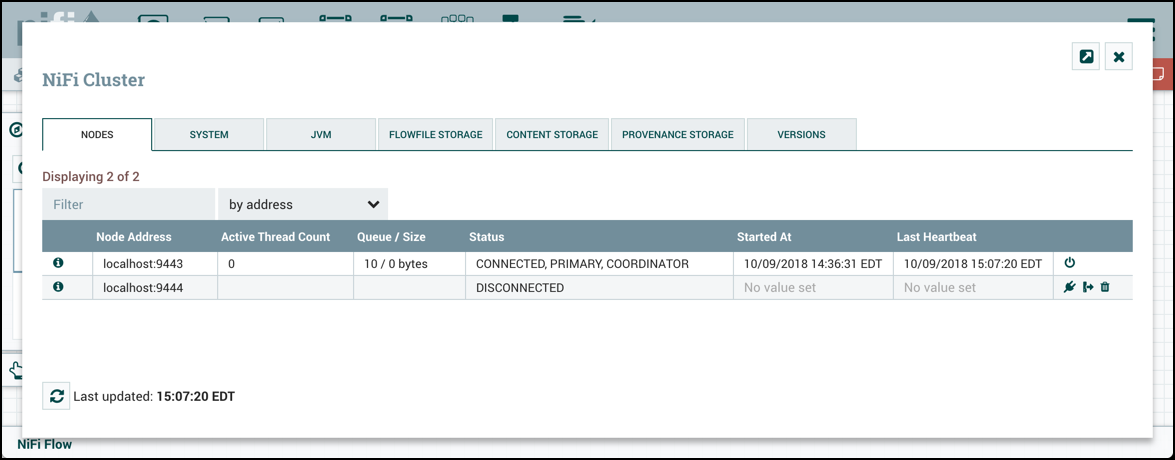

断开节点

DFM可以手动断开节点与集群的连接。节点也可能由于其他原因而断开连接,例如由于缺乏心跳。当节点断开连接时,集群协调器将在用户界面上显示公告。在解决断开连接节点的问题之前,DFM将无法对数据流进行任何更改。DFM或管理员需要对节点的问题进行故障排除,并在对数据流进行任何新的更改之前解决该问题。但是,值得注意的是,仅仅因为节点断开连接并不意味着它不起作用。这可能由于某些原因而发生,例如,当节点由于网络问题而无法与集群协调器通信时。

要手动断开节点,请从节点的行中选择"断开连接"图标(![]() )。

)。

断开连接的节点可以连接(![]() ),卸载(

),卸载(![]() )或删除(

)或删除(![]() )。

)。

并非所有处于"已断开连接"状态的节点都可以卸载。如果节点断开连接且无法访问,则节点无法接收卸载请求以启动卸载。此外,由于防火墙规则,可能会中断或阻止卸载。

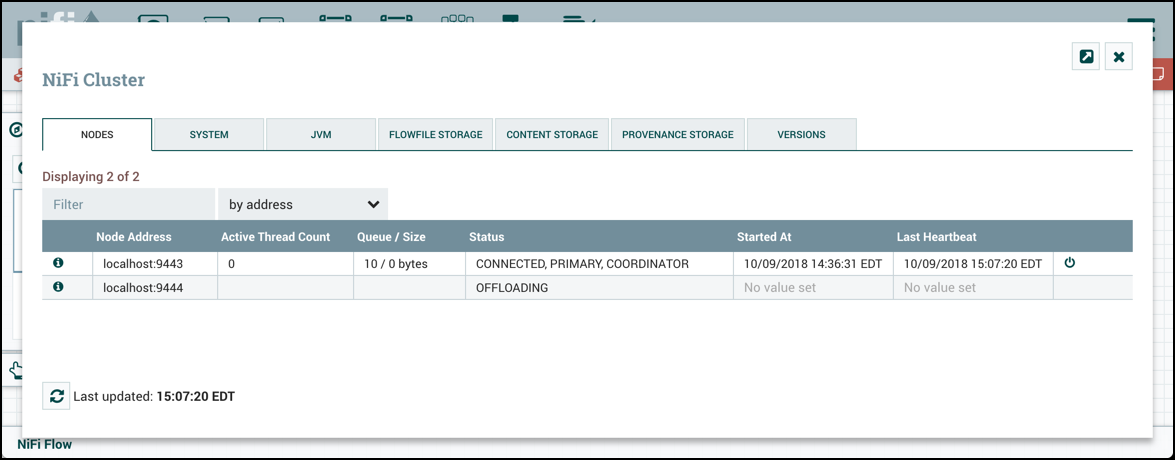

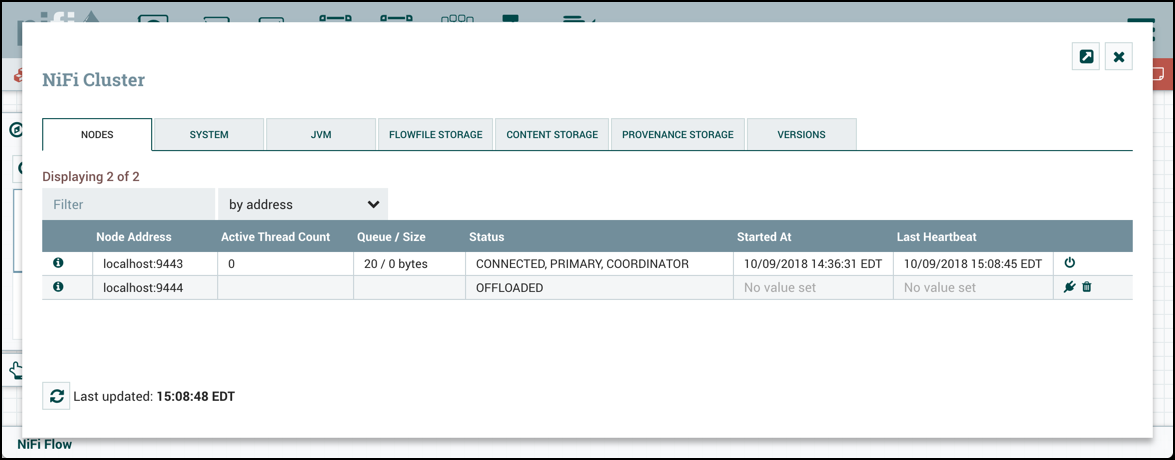

卸载节点

保留在断开连接的节点上的流文件可以通过卸载重新平衡到集群中的其他活动节点。在Cluster Management对话框中,为Disconnected节点选择"Offload"图标(![]() )。这将停止所有处理器,终止所有处理器,停止在所有远程进程组上传输,并将流文件重新平衡到集群中的其他连接节点。

)。这将停止所有处理器,终止所有处理器,停止在所有远程进程组上传输,并将流文件重新平衡到集群中的其他连接节点。

由于遇到错误(内存不足,没有网络连接等)而保持"卸载"状态的节点可以通过重新启动节点上的NiFi重新连接到集群。卸载的节点可以重新连接到集群(通过选择连接或重新启动节点上的NiFi)或从集群中删除。

删除节点

在某些情况下,DFM可能希望继续对流进行更改,即使节点未连接到集群也是如此。在这种情况下,DFM可以选择完全从集群中删除节点。在Cluster Management对话框中,为Disconnected或Offloaded节点选择"Delete"图标(![]() )。删除后,在重新启动节点之前,节点无法重新加入集群。

)。删除后,在重新启动节点之前,节点无法重新加入集群。

退役节点

停用节点并将其从集群中删除的步骤如下:

断开节点。

断开连接完成后,卸载节点。

卸载完成后,删除该节点。

删除请求完成后,停止/删除主机上的NiFi服务。

NiFi CLI节点命令

作为UI的替代方案,以下NiFi CLI命令可用于检索单个节点,检索节点列表以及连接/断开/卸载/删除(connecting/disconnecting/offloading/deleting ) 节点:

NiFi get-nodeNiFi get-nodesNiFi connect-nodeNiFi disconnect-nodeNiFi offload-nodeNiFi delete-node

有关更多信息,请参阅NiFi工具包指南中的[NiFi CLI]((./ToolkitGuide#NiFi_CLI)部分。

Flow Election

当集群首次启动时,NiFi必须确定哪个节点具有流的"正确"版本。这是通过对每个节点具有的流进行投票来完成的。当节点尝试连接到集群时,它会将其本地流的副本提供给集群协调器。如果尚未选择流"正确"流,则将节点的流与每个其他节点的流进行比较。如果另一个Node的流与此流匹配,则为此流投票。如果还没有其他节点报告相同的流,则此流将以一票投票的方式添加到可能选择的流池中。经过一段时间后(通过设置nifi.cluster.flow.election.max.wait.time属性配置)或一些节点有投票(通过设置nifi.cluster.flow.election.max.candidates属性),流被选为流的"正确"副本。然后,具有不兼容流的所有节点将与集群断开连接,而具有兼容流的节点将继承集群的流。选举是根据"民众投票"进行的,但需要注意的是,除非所有流量都是空的,否则获胜者永远不会是"空流"。这允许管理员删除节点的_flow.xml.gz_文件并重新启动节点,因为知道节点的流将不会被投票为"正确"流,除非找不到其他流。

基本集群设置

本节介绍由三个NiFi实例组成的简单三节点非安全集群的设置。

对于每个实例,都需要更新 nifi.properties 文件中的某些属性。特别是,应根据你的情况评估Web和集群属性并进行相应调整。所有属性都在本指南的 系统属性(System Properties)部分中描述; 但是,在本节中,我们将重点关注必须为简单集群设置的最小属性。

对于所有三个实例,可以使用默认设置保留集群公共属性。但请注意,如果更改这些设置,则必须在集群中的每个实例上设置相同的设置。

对于每个节点,要配置的最小属性如下:

在Web Properties部分下,设置要在其上运行节点的HTTP或HTTPS端口。另外,请考虑是否需要设置HTTP或HTTPS主机属性。集群中的所有节点都应使用相同的协议设置。

在State Management 将

nifi.state.management.provider.cluster属性设置为"集群状态提供程序"的标识符。确保已在_state-management.xml_文件中配置了集群状态提供程序。有关更多信息,请参阅配置状态提供程序在Cluster Node Properties下,设置以下内容:

nifi.cluster.is.node- 将此设置为 true。nifi.cluster.node.address- 将其设置为节点的标准主机名。如果留空,则默认为localhost。nifi.cluster.node.protocol.port- 将其设置为高于1024的开放端口(任何低端都需要root)。nifi.cluster.node.protocol.threads- 应该用于与集群中的其他节点通信的线程数。此属性默认为10。线程池用于将请求复制到所有节点,并且线程池的线程数永远不会少于此数量。它将根据需要增长到nifi.cluster.node.protocol.max.threads属性设置的最大值。nifi.cluster.node.protocol.max.threads- 应该用于与集群中其他节点通信的最大线程数。此属性默认为50。线程池用于对所有节点的复制请求,并且线程池将具有由nifi.cluster.node.protocol.threads属性配置的"核心"大小 。但是,如有必要,线程池会将活动线程数增加到此属性设置的限制。nifi.zookeeper.connect.string- 连接到Apache ZooKeeper所需的连接字符串。这是一个以逗号分隔的hostname:port对列表。例如,localhost:2181,localhost:2182,localhost:2183。这应该包含ZooKeeper仲裁中所有ZooKeeper实例的列表。nifi.zookeeper.root.node- 应在ZooKeeper中使用的根ZNode。ZooKeeper提供了一个类似目录的结构来存储数据。此结构中的每个"目录"称为ZNode。这表示应该用于存储数据的根ZNode或"目录"。默认值为/root。这对于正确设置很重要,因为NiFi实例尝试加入的集群取决于它连接到哪个ZooKeeper实例以及指定的ZooKeeper根节点。nifi.cluster.flow.election.max.wait.time- 指定在选择Flow作为"正确"流之前等待的时间量。如果已投票的节点数等于nifi.cluster.flow.election.max.candidates属性指定的数量,则集群将不会等待这么长时间。默认值为5 mins。请注意,一旦投票第一次投票,时间就会开始。nifi.cluster.flow.election.max.candidates- 指定集群中所需的节点数,以便提前选择流。这允许集群中的节点避免在开始处理之前等待很长时间,如果我们至少达到集群中的此数量的节点。

现在,可以启动集群。实例启动的顺序无关紧要。导航到其中一个节点的URL,用户界面应类似于以下内容:

故障排除